گزارش پیاده سازی معماری ارائه شده مقاله :

A synergistic multi-stage RAG architecture for boosting context relevance in data science literature

دانشگاه فردوسی مشهد

دانشکده مهندسی

گروه کامپیوتر

درس شناسایی آماری الگو

استاد : دکتر صدوقی یزدی

گزارش پروژه

نویسنده: دانیال آقاخانی زاده – دانشجوی کارشناسیارشد هوش مصنوعی

ایمیل : DanialAghakhanizadeh@gmail.com

فهرست مطالب

- نتایج

چکیده

در این گزارش، عملکرد رویکرد همافزایانه در معماریهای RAG با هدف افزایش ارتباط زمینهای و معنایی پاسخهای مدلهای زبانی بزرگ در بازیابی و تحلیل متون علمی و ادبیات پژوهشی حوزه علوم داده و یادگیری ماشین بررسی میشود. سپس نحوهی پیادهسازی معماری ارائهشده در مقالهی اصلی، با تمرکز بر ارزیابی خروجی مدلهای زبانی محلی (متنباز)، بهصورت مرحلهبهمرحله مورد مطالعه قرار میگیرد. در ادامه، روش ارزیابی این مدلها تشریح شده و در پایان، نتایج حاصل از عملکرد معماری همافزایانه در مدلهای محلی با یکدیگر و همچنین با مدل معرفیشده در مقاله مقایسه میگردد.

واژگان كليدي: مدل های زبانی بزرگ - بازیابی اطلاعات - پیشپردازش - همافزایی - همامتن

مقدمه

در دنیای امروز، با ورود مدلهای مولد هوش مصنوعی ـ بهویژه مدلهای زبانی بزرگ ـ به زندگی روزمرهی بشر و بهرهمندی از مزایای گستردهی آنها در پردازش اطلاعات، تولید محتوا و سایر کاربردها، همزمان با فرصتها، با چالشها و مخاطراتی نیز مواجه میشویم.

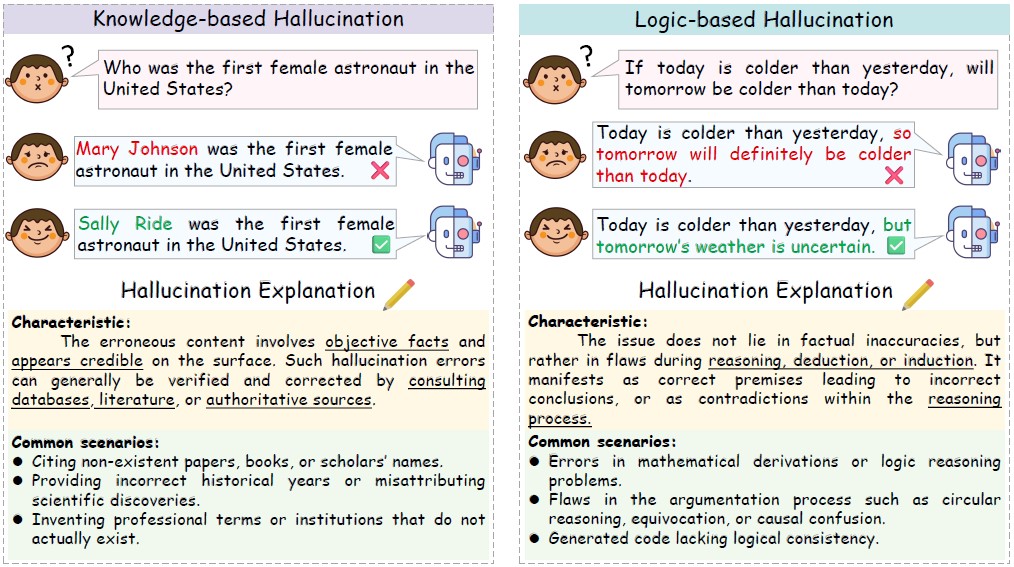

یکی از مهمترین چالشهای این مدلها، پدیدهی توهمزایی 1 یا تولید اطلاعات نادقیق و گمراهکننده در خروجی سیستمهاست. گرچه چنین خطاهایی در پاسخ به پرسشهای عمومی ممکن است چندان جدی تلقی نشوند، اما در کاربردهای تحقیقاتی یا محاسباتی قابل پذیرش نیستند و در حوزههای حساسی مانند پزشکی حتی میتوانند پیامدهای جبرانناپذیری بههمراه داشته باشند. علاوه بر این، استفاده از مدلهای عمومی زبانی در مسائل تخصصی، نبود آموزش کافی بهدلیل محدودیت منابع سختافزاری یا کمبود داده، و همچنین بهروز نبودن مدلها از جمله عواملی هستند که احتمال بروز توهم در خروجی این سیستمها را افزایش میدهند. به همین دلیل، تاکنون راهکارهای متعددی برای کاهش این مشکل ارائه شده است؛ از جمله روشهای مبتنی بر پایش و تشخیص توهمزایی [2]، مهندسی دستورات 2 [3]و تولید تقویتشده با بازیابی3. [4] [5]

تصویر ۱ – دو نمونه از انواع توهم : توهم بر مبنای منطق (سمت راست) – توهم بر مبنای دانش (سمت چپ)

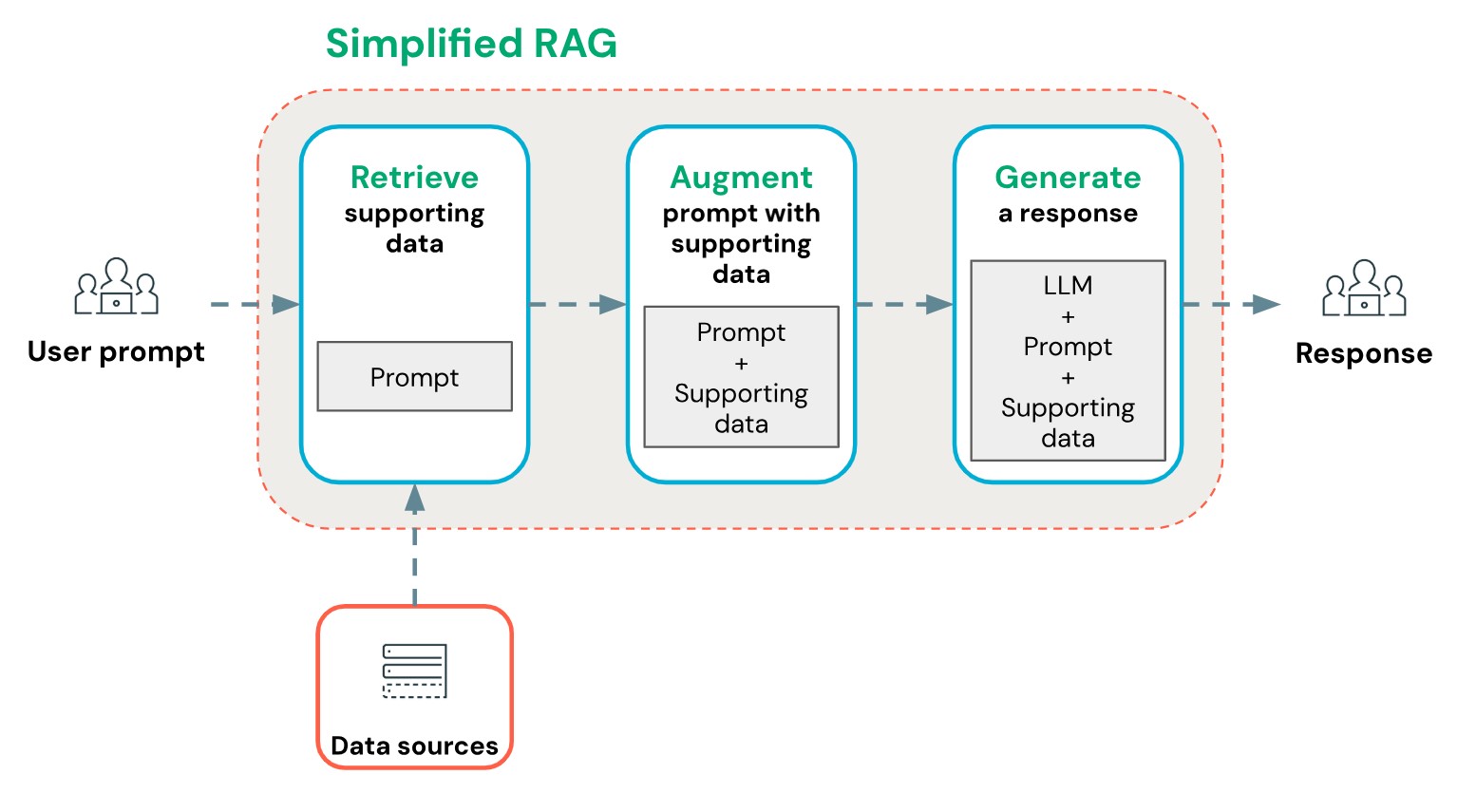

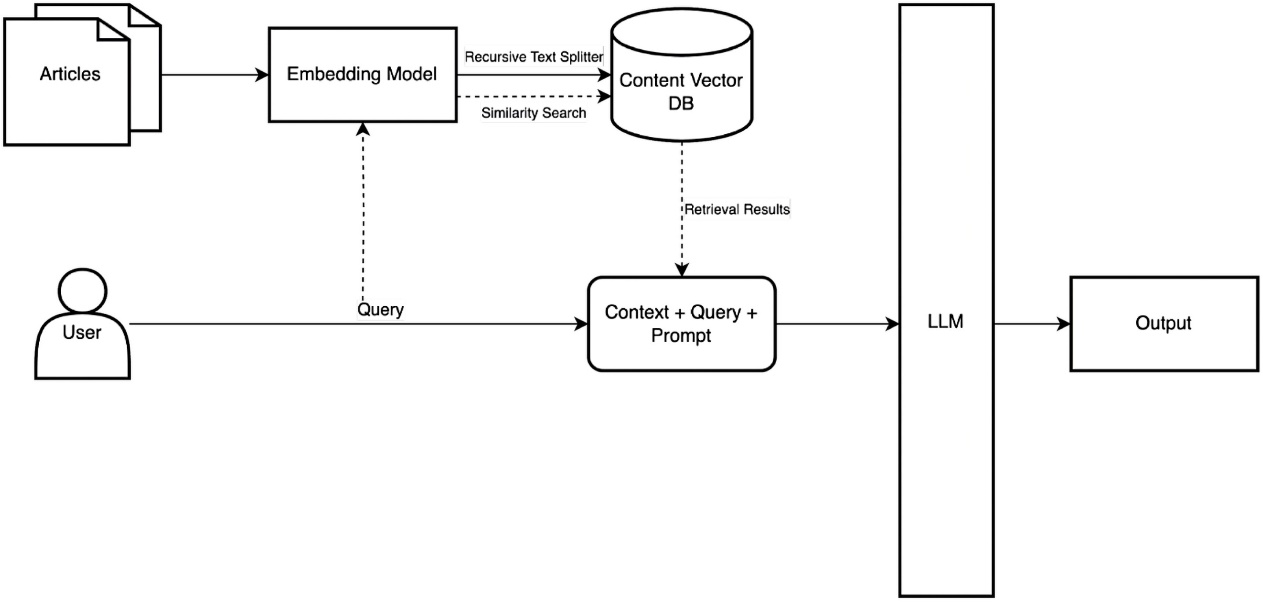

معماری RAG

بهطور کلی، در معماری RAG که نخستین بار در سال ۲۰۲۰ میلادی در حوزهی پردازش زبانهای طبیعی معرفی شد، در کنار پرسش ورودی کاربر، اطلاعات مرتبط با آن نیز به مدل زبانی داده میشود. در نتیجه، مدل بهجای اتکا صرف به دانش اولیهی خود، با توجه به این اطلاعات زمینهای 4 وادار میشود تا پاسخ دقیقتری تولید کند.

با توجه به محدودیت ورودیهای مدلهای زبانی ـ که به آنها توکنهای ورودی 5 گفته میشود (هر توکن بهطور تقریبی شامل چهار حرف الفبا است [6]) ـ و با در نظر گرفتن گستردگی نیاز کاربران و تعداد بالای پرسشها، لازم است این فرآیند بهصورت خودکار انجام شود. این فرآیند با کمک اتصال یک پایگاه داده ی اولیه به معماری RAG و سپس تبدیل دانش موجود به مقادیر اندیسگذاری شده برداری مقدور میگردد.

این خودکارسازی با اتصال یک پایگاه دادهی اولیه به معماری RAG و سپس تبدیل دانش موجود به مقادیر برداری اندیسگذاریشده امکانپذیر میگردد. به این ترتیب، با ورود پرسش کاربر به سیستم، ابتدا دانش مرتبط در فضای برداری پایگاه داده جستجو و بازیابی میشود. سپس همامتن 6 بازیابیشده در کنار پرسش کاربر به مدل داده میشود تا پاسخ نهایی تولید گردد.

از مهمترین مزایای معماری RAG میتوان به موارد زیر اشاره کرد:

۱- بهینهسازی توکنها: بازیابی همامتن مرتبط همراه با کاهش حجم دادههای ورودی و صرفهجویی در مصرف منابع.

۲- افزایش دقت: تولید پاسخها بر مبنای دادههای معتبر و قطعی خارج از مدل.

۳- مقیاسپذیری: امکان استفاده پویا از دیتاستهای بزرگ و متنوع.

۴- انعطافپذیری: قابلیت تلفیق آسان با سایر سیستمها و ابزارها.

۵- بهبود تجربهی کاربری: ارائه پاسخهای سریعتر و دقیقتر.

تصویر ۲ – ساختار کلی معماری RAG ساده

مزایا و چالش های RAG

از مهمترین چالشهای معماری RAG نیز میتوان به موارد زیر اشاره کرد:

۱- ارتباط معنایی دادههای بازیابیشده: کیفیت پاسخها به میزان ارتباط و اعتبار منابع بیرونی وابسته است.

۲- تاخیر در پاسخدهی: افزایش مراحل بازیابی میتواند زمان تولید پاسخ را بیشتر کند.

۳- انبارههای داده: دسترسی به دادههای ساختیافته و مدیریت روابط میان منابع همچنان دشوار است.

۴- محدودیتهای همامتن (Context): حجم زیاد دادههای بازیابیشده ممکن است از محدودیت توکنهای ورودی مدل زبانی فراتر رود؛ بنابراین نیاز به منقطعسازی 7 و مدیریت دادهها وجود دارد.

۵- ناترازی معنایی: اسناد بازیابیشده ممکن است فاقد ارتباطات ساختاری لازم برای استدلال عمیق مدل باشند.

با توجه به چالشهای مطرحشده، بهویژه محدودیتهای همامتن و محدودیت توکنها که در دادههای حجیم میتوانند منجر به سربار اطلاعات 8 شوند، بهبود عملکرد RAG در برخی کاربردها ـ بهویژه فعالیتهای پژوهشی ـ امری ضروری است.

برای رفع این مشکل، روشهای متعددی ارائه شدهاند؛ از جمله استفاده از گراف دانش در پایگاه داده (معماری GraphRAG [7])، رویکرد ComoRAG [8]، وLongRAG [9] که هر یک از این معماریها تلاش کردهاند تا محدودیتهای موجود در بازیابی و مدیریت دادههای حجیم را کاهش دهند.

یکی از جدیدترین رویکردها در این زمینه، پیادهسازی رویکرد همافزایانه 9 در معماری RAG است که با ترکیب چندین تکنیک بهصورت مرحلهای، بهبود چشمگیری در ارتباط معنایی و کارایی سیستم ایجاد میکند.

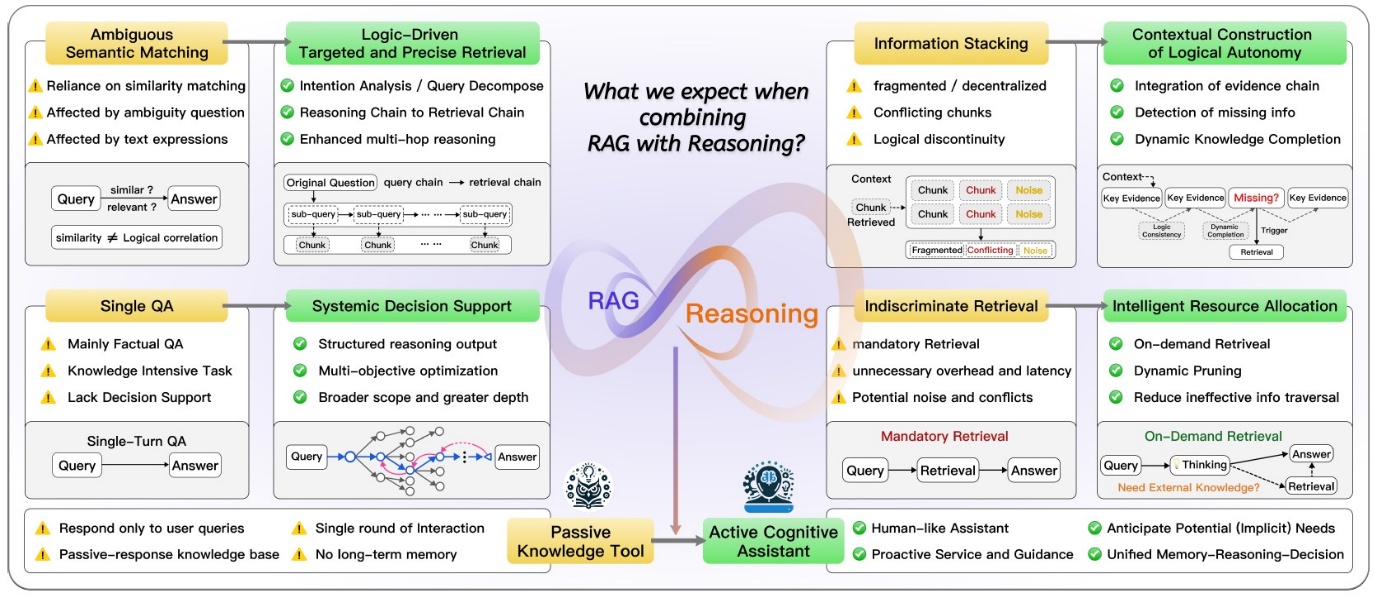

رویکرد هم افزایانه

بر اساس مقالهی “Synergizing RAG and Reasoning” که در سال ۲۰۲۵ منتشر شده است [9]، مفهوم همافزایی در معماری RAG بهصورت ترکیب تواناییهای کسب دانش خارجی در RAG با قابلیتهای استدلال درونی 10 مدلهای زبانی بزرگ تعریف میشود. این ترکیب در راستای بهبود کیفیت پاسخدهی به مسائل پیچیده بهکار گرفته میشود و موجب ارتقای دقت و عمق تحلیل در کاربردهای پژوهشی و تخصصی میگردد.

تصویر ۳ – مقایسه ی عملکرد RAG ساده (رنگ زرد) و RAG همافزا (رنگ سبز) - مقاله [9]

با توجه به تصویر ۳ مشاهده میشود که معماریهای RAG سنتی عمدتاً به شباهت معنایی در فرآیند بازیابی اطلاعات متکی هستند. این وابستگی موجب میشود که در بسیاری از موارد، اسناد بازیابیشده صرفاً بر اساس شباهت ظاهری به پرسش و نه بر اساس ارتباط منطقی یا استدلالی با موضوع مورد نظر انتخاب شوند.

در این مدلها، ورود حجم زیادی از اسناد بازیابیشده به مدل زبانی میتواند باعث سردرگمی مدلهای زبانی بزرگ شود. بهویژه زمانی که اسناد شامل اطلاعاتی باشند که فاقد انسجام معنایی یا ارتباط ساختاری باشند، مدل قادر به استنتاج دقیق نخواهد بود. این وضعیت منجر به بروز نقص در زنجیرهی استدلال یا همان «حلقهی مفقوده» در پاسخدهی میشود.

در مقابل، معماری RAG همافزایانه با بهرهگیری از استدلال چندمرحلهای، تجزیهی هدفمند پرسش، و بازیابی مبتنی بر زنجیرهی منطقی، تلاش میکند تا این چالشها را برطرف کند و پاسخهایی دقیقتر و منسجمتر ارائه دهد.

با این تفاسیر، همافزایی در معماری RAG از طریق ترکیب تواناییهای استدلالی مدل با قطعات معنایی 11 بازیابیشده، موجب میشود که مدل زبانی بتواند همانند یک محقق خبره، پاسخ یک مسئله را در میان اسناد متعدد جستجو کرده، مرتبطترین بخشها را در کنار یکدیگر قرار دهد، و در نهایت از میان این اطلاعات به نتیجهگیری و استدلال نهایی برسد.

این رویکرد حتی امکان تصمیمگیری سیستماتیک را برای مدل فراهم میسازد و معماری RAG را از یک ابزار منفعل 12 صرفاً تحقیقاتی، به یک دستیار شناختی فعال و تشخیصدهنده تبدیل میکند که قادر است نیازهای ضمنی کاربر را نیز پیشبینی و پاسخگویی کند.

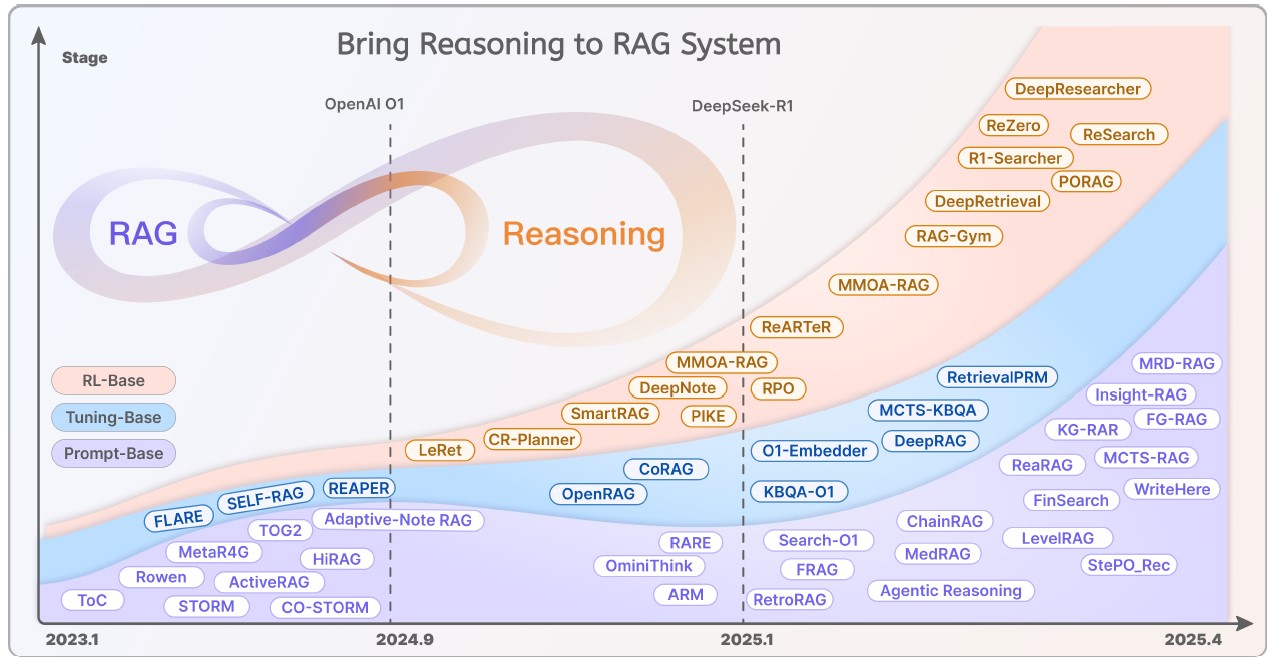

تصویر ۴ – روند تغییر رویکرد های RAG در سال های اخیر از بازیابی ساده به سمت همافزایی با توجه به انتشار مدل های زبانی مطرح – مقاله [9]

معماری پیشنهادی

همانطور که پیشتر اشاره شد، معماری RAG در کاربردهای تحقیقاتی و مطالعهی ادبیات آکادمیک 13 نقش بسزایی ایفا میکند. از جمله نمونههای موفق در این زمینه میتوان به فریمورک MKRAG اشاره کرد که با قابلیت تجمیع یافتهها از منابع دانش، در فرآیند تولید پاسخ در حوزهی پزشکی بهکار گرفته شده است. [11]

همچنین، مدلهایی با رویکرد استدلال موردمحور 14 در حوزهی بررسی پروندههای حقوقی توسعه یافتهاند [12] که با تلفیق اطلاعات زمینهای و تحلیل منطقی، پاسخهایی دقیق و ساختاریافته ارائه میدهند؛ موارد مشابه دیگری نیز وجود دارد که در متن اصلی مقالهی Aytar مفصلتر مورد بررسی قرار گرفتهاند.

به علاوه، بهمنظور پاسخگویی به چالشهای معماری RAG، نویسندگان مقاله پیشرفتهای ارائهشده در پژوهشهای اخیر را مورد توجه و بررسی قرار دادهاند. از جمله مهمترین این رویکردها میتوان به موارد زیر اشاره کرد:

۱- روش بازیابی عبارات متراکم 15 (DPR) [13]: این روش معماریای شامل دو انکودر BERT را معرفی میکند؛ یک انکودر برای پرسشها و دیگری برای متون بازیابیشده. با بهرهگیری از یادگیری تضادآمیز 16، شباهتهای معنایی میان پرسش و متن با دقت بیشتری شناسایی میشوند.

۲- روش جانمایی اسناد فرضی 17 (HyDE): در این رویکرد، ابتدا اسناد فرضی تولید میشوند که بهطور بالقوه میتوانند پاسخ پرسش را در خود داشته باشند. سپس این اسناد با متون واقعی مقایسه شده و نتایج بازیابی بهینهسازی میگردند.

۳- رویکردهای رتبهبندی 18 [14]: برای افزایش دقت در بازیابی، ابتدا مجموعهای از متون مرتبط انتخاب شده و سپس با استفاده از مدلهای دقیقتر، رتبهبندی مجدد آنها انجام میشود تا مرتبطترین پاسخها در اولویت قرار گیرند.

۴- تکنیکهای بسط چند کوئری 19 [15]: این روش مدل زبانی را قادر میسازد تا با تولید چندین نسخه بازنویسیشده از پرسش اولیه، نتایج متنوعتری را بازیابی کرده و مشکلاتی مانند ابهام معنایی یا عدم تطابق واژگان را پوشش دهد.

نویسندگان این مقاله، برای پاسخگویی به محدودیتهای معماریهای RAG سنتی و استاندارد ـ که پیشتر به آنها اشاره شد (از جمله سربار اطلاعات، ضعف در ارتباط همامتنهای بازیابیشده و چالش ناسازگاریهای جزئی حوزهمحور) ـ از روشهای نوین یادشده الگوبرداری کردهاند. بر اساس این رویکرد، آنها یک معماری پنجمرحلهای ارائه کردهاند که بهصورت همافزایانه طراحی شده و هدف آن ارتقای دقت، انسجام معنایی و کارایی در بازیابی و تولید پاسخهای علمی است.

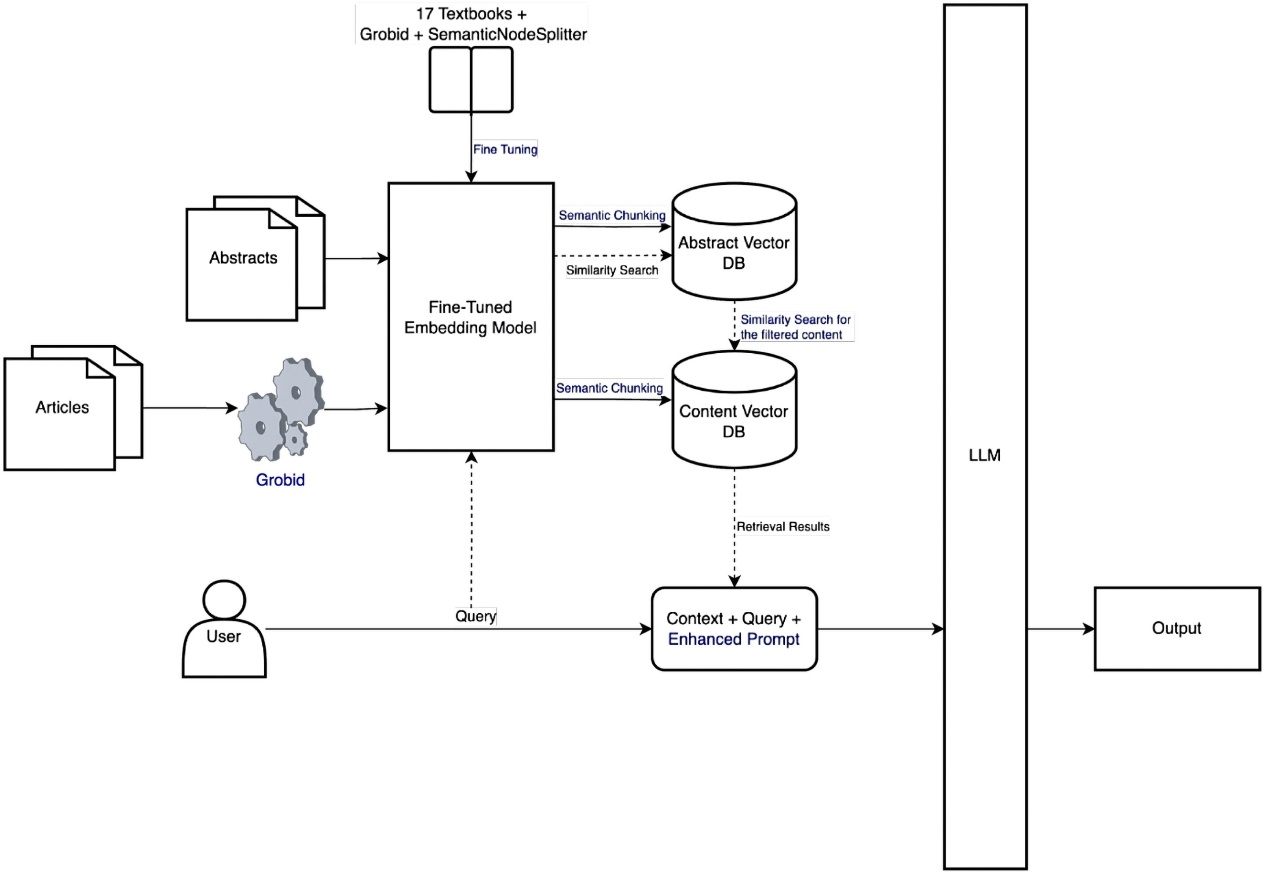

تصویر ۵ – معماری RAG ساده

تصویر ۶ – معماری پیشنهاد شده در مقاله Aytar

مراحل معماری پیشنهادی

بر اساس تصویر شماره ۶، روش ارائهشده شامل پنج مرحلهی اصلی است:

۱- پیشپردازش و پاکسازی اطلاعات منبع داده با استفاده از ابزار GROBID.

۲- فاینتیون و تنظیم مجدد مدلهای embedding بر اساس دادههای مرجع تخصصی.

۳- قطعهبندی معنایی (Semantic Chunking) برای حفظ انسجام و ارتباط مفهومی در دادههای منبع.

۴- بهکارگیری رویکرد اول-چکیده 20 در فرآیند بازیابی اطلاعات.

۵- استفاده از تکنیکهای دستور بهینهشده 21 در عملیات پرسش کاربر.

هر یک از این مراحل در بخش «پیادهسازی» بهصورت مفصلتر مورد بررسی قرار خواهند گرفت.

پیاده سازی: آماده سازی داده ها

جمع آوری اطلاعات و پیش پردازش

نویسندگان این مقاله برای جمعآوری دادههای مورد استفاده در مدل و ارزیابی عملکرد آن، مجموعهای شامل ۵۰ پرسش به همراه پاسخهای مرجع طراحی کردهاند تا امکان مقایسه نتایج فراهم شود. این پرسشها از موضوعات متنوعی همچون مخابرات، کشاورزی، مالی و سایر حوزهها انتخاب شدهاند.

بهعلاوه، طراحی پرسشها بهگونهای انجام شده است که سه مرحلهی اصلی از فریمورک CRISP-DM [16] ـ یکی از مدلهای شناختهشده در حوزهی دادهکاوی ـ را پوشش دهد:

• مرحله آمادهسازی دادهها: شامل ۱۰ پرسش.

• مرحله مدلسازی: شامل ۳۵ پرسش.

• مرحله ارزیابی: شامل ۵ پرسش.

این تقسیمبندی موجب میشود ارزیابی عملکرد معماری پیشنهادی در تمامی مراحل کلیدی فرآیند دادهکاوی صورت گیرد و نتایج بهصورت جامعتر مورد بررسی قرار گیرند.

به صورت دقیق تر:

۱- مرحله آمادهسازی دادهها:

• انتخاب ویژگیها: ۳ پرسش

• حذف دادههای پرت: ۲ پرسش

• کاهش ابعاد: ۵ پرسش

۲- مرحله مدلسازی:

• تولید دادههای ترکیبی: ۳ پرسش

• دستهبندی(Classification): ۵ پرسش

• رگرسیون(Regression): ۵ پرسش

• خوشهبندی(Clustering): ۵ پرسش

• یادگیری تقویتی(Reinforcement Learning): ۲ پرسش

• تشخیص تصاویر(Image Recognition): ۵ پرسش

• پردازش زبان طبیعی (NLP): ۵ پرسش

• تحلیل سریهای زمانی(Time Series Analysis) : ۵ پرسش

۳- مرحله ارزیابی عملکرد مدل:

• اختصاص ۵ پرسش برای سنجش کیفیت و دقت نتایج.

سپس نویسندگان مقاله، با توجه به پرسشهای طراحیشده، هر پرسش را به کمک مدل GPT-4o به سه بخش اصلی تبدیل کردند:

• تاپیک اصلی 22

• حوزههای کاربرد 23

• الزامات مشخص 24

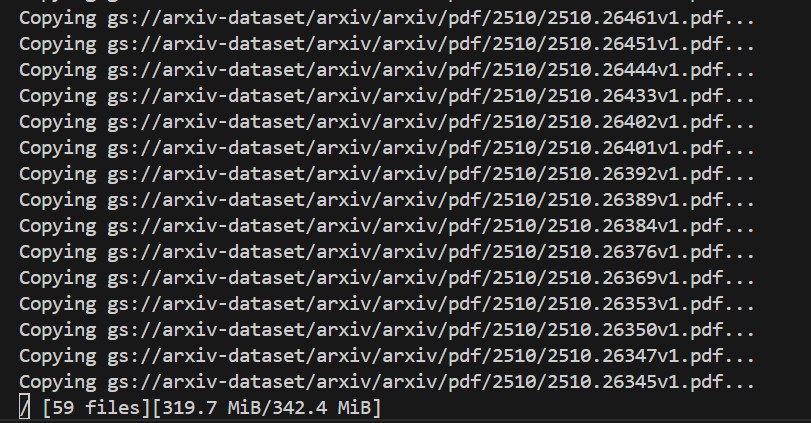

بر اساس موضوعات استخراجشده، مقالات مرتبط برای هر پرسش از طریق رابط برنامهنویسی arXiv API دریافت شدند. در مجموع حدود ۵۰۰۰ مقاله در قالب فایلهای PDF گردآوری شد تا بهعنوان منبع داده برای مراحل بعدی معماری مورد استفاده قرار گیرند.

با توجه به اهمیت مرحلهی ارزیابی، لازم است پرسشهای طراحیشده و پاسخهای مرجع از صحت و دقت بالایی برخوردار باشند. بهمنظور اطمینان بیشتر در پیادهسازی مقاله، ابتدا فهرستی شامل حدود ۵۰۰۰ مقاله از موضوعات مختلف از طریق رابط برنامهنویسی arXiv API گردآوری شد و سپس نسخههای آینهی 25 آنها از طریق پایگاه دادهی گوگل بارگیری گردید.

در ادامه، با استفاده از ۵۰ پرسش طراحیشده توسط نویسندگان، پاسخهای تولیدشده توسط مدلهای زبانی مختلف مورد ارزیابی و مقایسه قرار گرفتند. نتایج این مقایسه در بخش «نتایج» بهصورت تفصیلی ارائه خواهد شد.

برای دریافت مقالات، ابتدا لازم است ابزارها و کتابخانههای مورد نیاز نصب شوند:

۱- ابزار gsutil: این ابزار که توسط Google Cloud ارائه شده است [17]، امکان مدیریت حافظههای ابری را فراهم میکند. از طریق آن میتوان عملیاتهایی مانند بارگیری 26 ، بارگذاری 27 و سایر تعاملات مرتبط با لیستهای سطلی 28 را از طریق خط فرمان اجرا کرد.

برای نصب و راهاندازی ابزار gsutil مراحل زیر دنبال میشوند:

-در سیستم عامل ویندوز:

فایل نصب Google Cloud CLI را از لینک زیر دریافت کرده:

https://dl.google.com/dl/cloudsdk/channels/rapid/GoogleCloudSDKInstaller.exe

یا میتوان در PowerShell دستور زیر را وارد کرد:

(New-Object Net.WebClient).DownloadFile("https://dl.google.com/dl/cloudsdk/channels/rapid/GoogleCloudSDKInstaller.exe", "$env:Temp\GoogleCloudSDKInstaller.exe")

$env:Temp\GoogleCloudSDKInstaller.exe

-راهنمای نصب برای سایر سیستمعاملها و توزیعهای لینوکس در لینک زیر در دسترس است:

https://cloud.google.com/storage/docs/gsutil_install

۲- کتابخانهی feedparser: این کتابخانه در زبان Python برای پردازش و تجزیهی فیدهای RSS و Atom مورد استفاده قرار میگیرد و امکان استخراج و مدیریت دادههای منتشرشده در این فیدها را فراهم میسازد. برای نصب این کتابخانه کافی است تا دستور pip install feedparser در محیط خط فرمان پایتون اجرا شود.

دریافت مقالات

کد زیر نحوه ی دریافت مقالات را نشان میدهد:

import feedparser

import os

import time

import json

from collections import defaultdict

MAX_TOTAL_PAPERS = 5200

CATEGORIES = ["cs.LG", "stat.ML", "cs.CL", "cs.AI", "cs.CV", "cs.NE", "cs.IR", "cs.CR", "cs.SE", "cs.SI"]

BATCH_SIZE = 100

category_papers = defaultdict(list)

در ابتدای کد، کتابخانههای مورد نیاز برای اجرای عملیات فراخوانی میشوند. این کتابخانهها شامل ابزارهایی برای پردازش فیدها، مدیریت فایلها، زمانبندی، کار با دادههای JSON و ساختارهای دادهای پیشرفته هستند.

پس از آن، متغیرهای اصلی برای کنترل فرآیند دریافت مقالات تعریف میشوند:

• MAX_TOTAL_PAPERS: این متغیر حداکثر تعداد مقالاتی را که باید از پایگاه داده دریافت شوند مشخص میکند (در اینجا ۵۲۰۰ مقاله).

• CATEGORIES: در این متغیر، فهرستی از دستهبندیها و موضوعات علمی مورد نظر تعریف شده است؛ مانند یادگیری ماشین، هوش مصنوعی، بینایی ماشین، پردازش زبان طبیعی و سایر حوزههای مرتبط.

• BATCH_SIZE: این متغیر اندازهی هر دستهی بارگیری مقالات را تعیین میکند (در اینجا ۱۰۰ مقاله در هر بارگیری). بستهبندی دادهها علاوه بر مدیریت بهتر منابع سیستم، نقش مهمی در افزایش سرعت جمعآوری اطلاعات و دریافت مقالات دارد. به این ترتیب، بهجای پردازش کل دادهها بهصورت یکجا، دادهها در بستههای کوچکتر تقسیم شده و بهصورت مرحلهای بارگیری میشوند. این روش هم فشار روی حافظه و پردازنده را کاهش میدهد و هم امکان کنترل بهتر جریان دادهها را فراهم میسازد.

• category_papers: یک ساختار دادهای از نوع defaultdict(list) برای ذخیرهی مقالات دریافتشده بر اساس دستهبندیها.

هر کد از فهرست زیر، معرف یک شاخهی پژوهشی در پایگاه دادهی arXiv میباشد:

| عنوان | کد دسته بندی |

|---|---|

| Machine Learning (علوم کامپیوتر) | cs.LG |

| Machine Learning (آمار) | stat.ML |

| Computation and Language | cs.CL |

| Artificial Intelligence | cs.AI |

| Computer Vision and Pattern Recognition | cs.CV |

| Neural and Evolutionary Computing | cs.NE |

| Information Retrieval | cs.IR |

| Cryptography and Security | cs.CR |

| Software Engineering | cs.SE |

| Social and Information Networks | cs.SI |

جدول ۱ – کد های مربوط به شاخه های پژوهشی در arXiv

سپس تابع ()fetch_metadata برای واکشی و ذخیرهسازی اطلاعات مقالات از پایگاه دادهی arXiv به صورت زیر تعریف میشود:

def fetch_metadata():

base_url = "http://export.arxiv.org/api/query?"

total_collected = 0

for cat in CATEGORIES:

print(f"\n📚 Fetching category: {cat}")

for start in range(0, 750, BATCH_SIZE):

query = f"cat:{cat}"

url = (

f"{base_url}search_query={query}&start={start}&max_results={BATCH_SIZE}"

f"&sortBy=submittedDate&sortOrder=descending"

)

feed = feedparser.parse(url)

if len(feed.entries) == 0:

print(" ⚠️ No more results for this category.")

break

for e in feed.entries:

pid = e.id.split("/")[-1]

paper = {

"id": pid,

"title": e.title.strip(),

"published": e.published,

"category": cat,

}

category_papers[cat].append(paper)

print(f" ✅ Batch {start}-{start+BATCH_SIZE}, total={len(category_papers[cat])}")

time.sleep(2)

all_papers = []

for cat in CATEGORIES:

all_papers.extend(category_papers[cat])

json.dump(all_papers, open("arxiv_papers.json", "w", encoding="utf-8"), indent=2)

print("\n📊 Paper counts per category:")

for cat in CATEGORIES:

print(f" - {cat}: {len(category_papers[cat])}")

return category_papers

همانطور که مشاهده میشود، تابع متادیتای مقالات را بر اساس موضوعات تعریفشده (cat) از arXiv API جمعآوری میکند. سپس دادههای استخراجشده در فایل arxiv_papers.json ذخیره میشوند. در ادامه، تعداد مقالات دریافتشده برای هر دستهبندی نمایش داده شده و در نهایت، لیست کامل مقالات در ساختار category_papers بازگردانده میشود تا در مراحل بعدی پردازش مورد استفاده قرار گیرد.

در ادامه، در بخش بعدی کد، تابع ()select_papers تعریف شده است که وظیفهی انتخاب مقالات مورد نظر از میان دادههای جمعآوریشده را بر عهده دارد:

def select_papers(category_papers):

selected = []

total_available = sum(len(p) for p in category_papers.values())

print(f"\n📦 Total available papers: {total_available}")

for cat in CATEGORIES:

cat_count = len(category_papers[cat])

share = int((cat_count / total_available) * MAX_TOTAL_PAPERS)

selected.extend(category_papers[cat][:share])

print(f" ✅ Selected {share} papers from {cat}")

print(f"\n🎯 Total selected for GCS path generation: {len(selected)}")

return selected

در کد بالا، روند اجرای این تابع به صورت زیر است:

• ابتدا مجموع کل مقالات موجود در همهی دستهبندیها محاسبه و نمایش داده میشود.

• سپس برای هر دستهبندی، نسبت تعداد مقالات آن دسته به کل مقالات محاسبه میگردد.

• بر اساس این نسبت، سهم هر دسته از مقدار آستانهی تعیینشده (MAX_TOTAL_PAPERS = 5200) مشخص میشود.

• به عنوان مثال، اگر دستهی cs.LG حدود ۲۰٪ از کل ۷۰۰۰ مقالهی اولیه را تشکیل دهد، در انتخاب نهایی نیز حدود ۲۰٪ از ۵۲۰۰ مقالهی هدف به این دسته اختصاص داده خواهد شد.

• در نهایت، لیست مقالات انتخابشده در خروجی بازگردانده میشود تا برای مراحل بعدی (مانند تولید مسیرهای ذخیرهسازی یا پردازش بیشتر) مورد استفاده قرار گیرد.

سپس لیست نهایی مقالات انتخابشده (ذخیرهشده در متغیر selected) به تابع نهایی ارسال میشود. این تابع وظیفه دارد لینکهای دانلود مربوط به هر مقاله را ایجاد کرده و برای استفادههای بعدی آماده سازد.

def generate_gcs_paths(papers, output_file="gcs_paths.txt"):

paths = []

for p in papers:

pid = p["id"]

prefix = pid[:4]

gcs_path = f"gs://arxiv-dataset/arxiv/arxiv/pdf/{prefix}/{pid}.pdf"

paths.append(gcs_path)

with open(output_file, "w") as f:

f.write("\n".join(paths))

print(f"\n✅ GCS paths saved in: {output_file}")

print(f"📥 To download, run:\n gsutil -m cp -I ./pdfs < {output_file}")

تابع ()generate_gcs_paths وظیفهی تولید مسیرهای دانلود مقالات از فضای ابریGoogle Cloud Storage (GCS) را بر عهده دارد. روند اجرای این تابع به صورت زیر است:

• ابتدا برای هر مقاله، شناسهی مقاله (id) استخراج میشود.

• سپس چهار رقم ابتدایی شناسه به عنوان prefix در مسیر ذخیرهسازی استفاده میگردد.

• مسیر نهایی فایل PDF مقاله بر اساس قالب زیر ساخته میشود:

gs://arxiv-dataset/arxiv/arxiv/pdf/{prefix}/{id}.pdf

• و همهی مسیرهای ساختهشده در یک لیست جمعآوری میشوند.

• در پایان، این لیست در فایل متنی gcs_paths.txt ذخیره میشود تا در مراحل بعدی برای دانلود دستهای مقالات مورد استفاده قرار گیرد.

• همچنین دستور نمونهای برای دانلود فایلها با ابزار gsutil چاپ میشود تا کاربر بتواند مقالات را بهصورت خودکار دریافت کند.

در پایان این کد، pipeline دستورات فراخوانی توابع نوشته شده و سپس فایل .py این کد پایتون اجرا میگردد.

if __name__ == "__main__":

category_papers = fetch_metadata()

selected_papers = select_papers(category_papers)

generate_gcs_paths(selected_papers)

خروجی اجرای این برنامه به صورت زیر خواهد بود:

(venv) /root/myprojects/synergisticrag/download_arxiv_pdfs.py

📚 Fetching category: cs.LG

✅ Batch 0-100, total=100

✅ Batch 100-200, total=200

⚠️ No more results for this category.

.

...

.....

📊 Paper counts per category:

- cs.LG: 200

- stat.ML: 400

- cs.CL: 400

- cs.AI: 100

- cs.CV: 100

- cs.NE: 500

- cs.IR: 300

- cs.CR: 300

- cs.SE: 500

- cs.SI: 800

📦 Total available papers: 3600

✅ Selected 288 papers from cs.LG

✅ Selected 577 papers from stat.ML

✅ Selected 577 papers from cs.CL

✅ Selected 144 papers from cs.AI

✅ Selected 144 papers from cs.CV

✅ Selected 722 papers from cs.NE

✅ Selected 433 papers from cs.IR

✅ Selected 433 papers from cs.CR

✅ Selected 722 papers from cs.SE

✅ Selected 1155 papers from cs.SI

🎯 Total selected for GCS path generation: 5200

✅ GCS paths saved in: gcs_paths.txt

📥 To download, run:

gsutil -m cp -I ./pdfs < gcs_paths.txt

سپس با اجرای دستور gsutil -m cp -I ./pdfs < gcs_paths.txt در ترمینال (powershell یا Bash) مقالات دریافت میشوند.

نتیجه ی اجرای دستور مشابه زیر خواهد بود:

تصویر ۷ – ترمینال bash در حال اجرای دستور gsutil

پیشپردازش اطلاعات

پس از دریافت فایلهای مقالات و قرار دادن آنها در پوشهی pdfs، مرحلهی پیشپردازش آغاز میشود. در این مرحله، فرمت مقالات از PDF به TEI تبدیل خواهد شد.

برای پیشپردازش و تبدیل فایلهای PDF به فرمتهای متنی مانند txt، xml یا سایر قالبهای قابل پردازش، ابزارهای متنوعی ارائه شدهاند.

• ابزارهای عمومی برای تبدیل فرمت:

o ابزار PyMuPDF

o ابزار PDFplumber

o ابزار PyPDF2

این ابزارها امکان استخراج متن از فایلهای PDF و ذخیرهسازی آن در قالبهای سادهتر را فراهم میکنند.

• ابزارهای تخصصیتر:

o ابزار Camelot [18] این ابزار بهطور ویژه برای استخراج جدولها از فایلهای PDF طراحی شده و در پروژههایی که نیاز به پردازش دادههای جدولی دارند بسیار کاربردی است.

برای پیشپردازش و پاکسازی متن، عملیاتهایی مانند حذف علائم زائد و نویز (کاراکترهای ویژه)، جداسازی یا توکنسازی کلمات و سادهسازی دادهها انجام میشود. در این زمینه، ابزارهای NLP و پردازش متن متعددی ارائه شدهاند.

یکی از ابزارهای پرکاربرد، NLTK است که امکانات متنوعی برای پردازش زبان طبیعی فراهم میکند. به عنوان نمونه، میتوان از ماژول stopwords در این کتابخانه برای حذف کلمات توقف (مانند «و»، «از»، «به») استفاده کرد تا متن نهایی تمیزتر و آمادهی تحلیل شود.

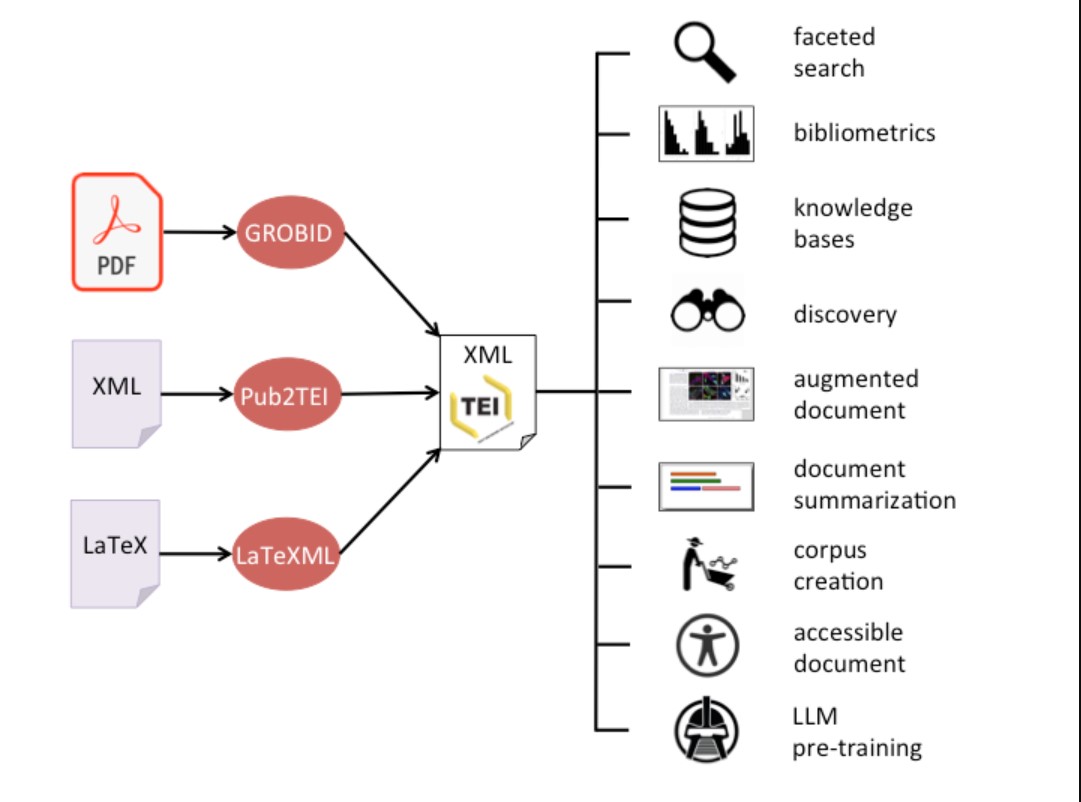

نویسندگان این مقاله نیز برای انجام عملیات های فوق (شامل پاکسازی متن، تبدیل فرمت، شناسایی جملات و حذف نویز) از ابزار GROBID [19] استفاده کردهاند.

اما GROBID چیست و چه مزایا و برتریهایی نسبت به سایر ابزارهای مشابه دارد؟

GROBID که مخفف “GeneRation Of BIbliographic Data” 29 است، یک کتابخانه و ابزار مبتنی بر یادگیری ماشین میباشد. این ابزار با هدف استخراج، تجزیهوتحلیل و بازسازی اسناد علمی طراحی شده و قادر است فایلهایی با ساختارهایی مانند PDF را به قالبهای متنی استاندارد نظیر XML/TEI تبدیل کند. تمرکز اصلی GROBID بر نشریات علمی، مقالات پژوهشی و گزارشهای فنی است و به همین دلیل در پروژههای مرتبط با پردازش و سازماندهی دادههای علمی کاربرد گستردهای دارد.

از مهمترین کاربرد های ابزار GROBID میتوان به موارد زیر اشاره کرد:

- استخراج سربرگ 30 و تجزیه و تحلیل 31 مقالات: اطلاعاتی مانند چکیده، نویسندگان، کلمات کلیدی و سایر داده های اولیه.

- استخراج منابع و متادیتا: شناسایی شناسههای استاندارد مانند DOI، PMID و دیگر دادههای کتابشناختی با استفاده از مدلهای یادگیری عمیق در حوزه استناد 32.

- شناسایی محتوای استناد: تشخیص بخشهایی از متن که به منابع دیگر ارجاع دادهاند و شناسایی مراجعی که به آنها استناد شده است.

- تحلیل منابع: بررسی و سازماندهی دادههای مربوط به منابع علمی.

- تحلیل نامها: شناسایی و تجزیهی نام اشخاص (نام کوچک، نام میانه، نام خانوادگی و…) در سربرگ و منابع، با استفاده از دو مدل مجزا.

- تحلیل پیوندها و آدرسها: استخراج و پردازش لینکها و نشانیهای موجود در متن.

- تحلیل و نرمالسازی تاریخها: شناسایی تاریخهای موجود در متن و تبدیل آنها به قالب استاندارد.

- سایر قابلیتها: شامل مجموعهای از ابزارهای کمکی برای پردازش و ساختارسازی دادههای علمی.

در نتیجهی این فرآیندهای پردازشی برای فایلهای PDF، ابزار GROBID بیش از ۵۵ برچسب نهایی را برای ساختارهای ریزدانه 33 شده مدیریت و پردازش میکند. این برچسبها شامل انواع متادیتا و ساختارهای متنی مانند پاراگرافها، تیترها، شرح تصاویر و سایر اجزای متن هستند.

در کنار کاربردهای ذکرشده، ابزار GROBID مزایای دیگری نیز دارد که آن را از سایر ابزارهای مشابه متمایز میسازد. از جمله میتوان به سرعت بالا و مقیاسپذیری در پردازش دادههای حجیم اشاره کرد؛ بهطور مثال، یک سیستم مجهز به پردازندهی ۱۶ هستهای یا ۱۶ رشتهای و ۳۲ گیگابایت حافظهی رم قادر است روزانه حدود ۹۱۵ هزار فایل PDF یا نزدیک به ۲۰ میلیون صفحه را پردازش کند. علاوه بر این، ماژولار بودن مدلهای عمیق در این کتابخانه و بازکاربردپذیری 34 آنها در سایر برنامهها و کدها، از دیگر ویژگیهایی است که GROBID را برجسته میسازد.

لذا در این پژوهش نیز برای انجام فرآیند پیشپردازش و اصلاح فایلهای متنی دانلودشده از ابزار GROBID استفاده شده است.

تصویر ۸ – نحوه ی عملکرد GROBID – تصویر ارائه شده توسط توسعه دهنده

نصب GROBID

برای نصب و راهاندازی GROBID، در ابتدا لازم است که Docker بر روی سیستم نصب شده باشد. این پیشنیاز امکان اجرای آسان و قابل حمل سرویس GROBID را فراهم میکند و محیطی ایزوله برای مدیریت وابستگیها و اجرای پایدار آن ایجاد مینماید.

- برای دریافت نسخهی کامل و استفاده از قابلیتهای آن روی GPU، میتوان از دستور زیر بهره گرفت:

docker run --rm --gpus all --init --ulimit core=0 -p 8070:8070 grobid/grobid:0.8.2-full

این دستور باعث میشود:

• ایمیج کاملGROBID (نسخهی 0.8.2 full-) دریافت و اجرا شود.

• پردازشها بر روی GPU سیستم با سرعت و قدرت بیشتری انجام گیرد.

• سرویس GROBID روی پورت 8070 در دسترس قرار گیرد.

• گزینهی rm- پس از پایان اجرا کانتینر را حذف کند و سیستم تمیز باقی بماند.

• گزینهی init- و ulimit core=0-- برای مدیریت بهتر منابع و جلوگیری از تولید فایلهای core dump استفاده شوند.

- برای نصب و بهکارگیری نسخهی سبک GROBID که تنها بر روی CPU اجرا میشود، میتوان از دستور زیر استفاده کرد:

docker run --rm --init --ulimit core=0 -p 8070:8070 grobid/grobid:0.8.2-crf

در این حالت:

• خروجی حاصل دقت کمتری نسبت به نسخهی کامل دارد.

• اما حجم image دریافتشده کمتر است.

• همچنین میزان مصرف حافظهی RAM کاهش مییابد.

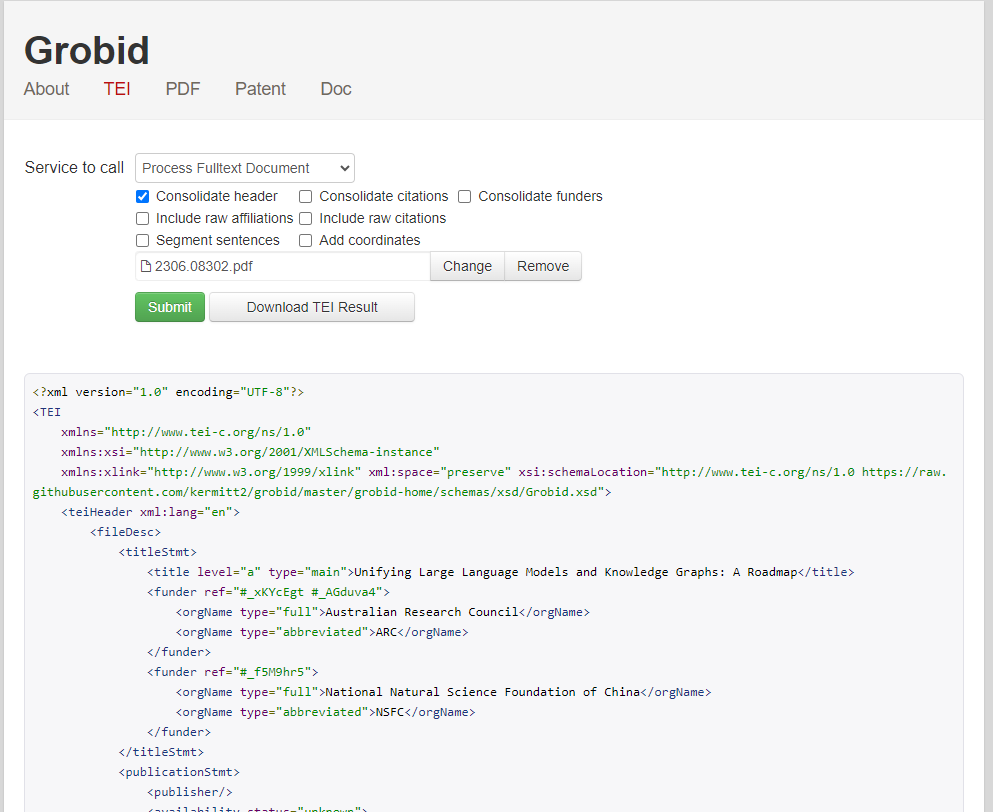

تصویر ۹ – نمایی از رابط کاربری GROBID در localhost

فرآیند پیش پردازش

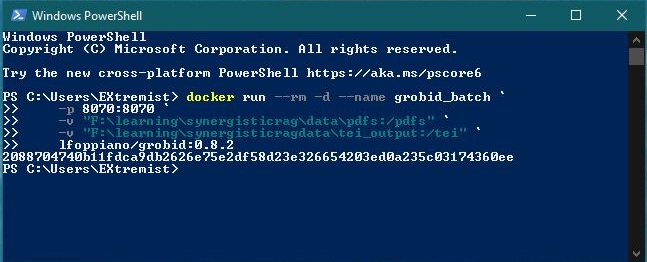

برای انجام عملیاتهای پیشپردازش، ابتدا همانطور که پیشتر اشاره شد، کانتینر GROBID را با استفاده از دستور زیر فراخوانی میکنیم:

docker run --rm -d --name grobid_batch `

-p 8070:8070 `

-v " “Enter pdfs location here” :/pdfs" `

-v " “Enter TEI outputs location here” :/tei" `

lfoppiano/grobid:0.8.2

در این دستور:

• خط اول: کانتینر تعریف شده و نام آن grobid_batch تعیین میشود. گزینهی rm- مشخص میکند که پس از توقف کانتینر، بهطور خودکار حذف شود.

• خط دوم: پورت اجرای سرویس روی 8070 تنظیم میشود تا دسترسی به GROBID امکانپذیر باشد.

• خط سوم: مسیر فایلهای ورودی ( PDF ها) برای کانتینر تعریف میشود.

• خط چهارم: مسیر خروجی پردازش(فایلهای TEI) مشخص میگردد.

• خط آخر: از نسخه ی رسمی GROBID در Docker hub استفاده میشود. (در صورت نیاز، میتوان از نسخههای جایگزین مانند grobid/grobid:0.8.2-full و grobid/grobid:0.8.2-crf نیز بهره گرفت.)

در ادامه، اسکریپت پایتون تدوینشده برای انجام عملیاتهای پیشپردازش اجرا میگردد:

import os, requests, json

from tqdm import tqdm

from time import sleep

PDF_DIR = r" Enter pdfs location here "

OUT_DIR = r" Enter TEI outputs location here "

API_URL = "http://localhost:8070/api/processFulltextDocument"

BATCH_SIZE = 5

RETRY_LIMIT = 1

TIMEOUT = 180

در ابتدای کد:

• در خط اول، کتابخانههای لازم برای مدیریت فایلها در سیستم عامل (os)، برقراری ارتباط با API (requests) و کار با دادههای JSON فراخوانی میشوند.

• در خط دوم و سوم، ابزارهای کمکی شامل tqdm برای نمایش نوار پیشرفت و sleep برای مدیریت زمانبندی در پایپلاین پردازش وارد میشوند.

سپس در خطوط مربوط به آدرس ها:

• PDF_DIR: مسیر فایلهای ورودی (PDF ها) را مشخص میکند.

• OUT_DIR: مسیر فایلهای خروجی (TEI) را تعیین میکند.

• API_URL: آدرس پردازش مورد نظر در سرویس GROBID را مشخص مینماید. در اینجا از ماژول

پردازش کامل processFulltextDocument استفاده شده است که شامل عملیاتهایی مانند حذف نویز و یکسانسازی کلمات است.

در سه خط پایانی:

• BATCH_SIZE = 5: اندازه هر بستهی ورودی را تعیین میکند (پردازش ۵ فایل در هر نوبت اجرا).

• RETRY_LIMIT = 1: تعداد تلاش مجدد در صورت عدم موفقیت در پردازش را مشخص میکند.

• TIMEOUT = 180: حداکثر زمان پردازش هر فایل (بر حسب ثانیه) را تعیین میکند.

سپس پارامترهای مربوط به عملیات پیشپردازش مطابق کد زیر مشخص میگردند:

PARAMS = {

"consolidateHeader": 1,

"consolidateCitations": 0,

"segmentSentences": 1,

"generateIDs": "true",

"teiCoordinates": "false",

"removeInvalidXMLChars": "true"

}

در این قسمت:

• خط اول: consolidateHeader اطلاعات سربرگ هر مقاله را (شامل عنوان، نویسندگان و موسسات) را تجمیع و ادغام میکند.

• خط دوم: consolidateCitations یا فرآیند ادغام ارجاعات است که با توجه نیازمندی به اتصال پایگاه داده و اطلاعات جانبی و عدم کاربرد در معماری RAG غیر فعال میشود.

• خط سوم: segmentSentences که وظیفه ی شناسایی و تفکیک جملات از یکدیگر را دارد. (این مورد با توجه به معماری مقاله و فرآیند قطعه بندی معنایی در مرحله ی بعد نقش کلیدی و حیاتی دارد.)

• خط چهارم: generateIDs که برای هر بخش پردازش شده یک شناسه منحصر به فرد تولید میکند تا شناسایی و پردازش ارجاعات انجام شود.

• خط پنجم: teiCoordinates که مختصات هر عنصر را در صفحه تشخیص میدهد.(این مورد نیز غیرضروری است.)

• خط ششم: removeInvalidXMLChars که وظیفه ی آن شناسایی و حذف کاراکتر هایی است که منجر به خرابی خروجی XML میشود. لذا فعال سازی آن ضروری است.

در قسمت بعد:

os.makedirs(OUT_DIR, exist_ok=True)

meta_file = os.path.join(OUT_DIR, "metadata.jsonl")

fail_file = os.path.join(OUT_DIR, "failed.txt")

pdf_files = [

f for f in os.listdir(PDF_DIR)

if f.lower().endswith(".pdf")

and not os.path.exists(os.path.join(OUT_DIR, f.replace(".pdf", ".tei.xml")))

]

• در خط اول برای اطمینان بیشتر، مسیر خروجی (OUT_DIR) در صورت عدم وجود ایجاد میشود تا فایلهای پردازششده در آن ذخیره گردند.

• در خط دوم و سوم :

o فایل metadata.jsonl برای ذخیرهی متادیتای مربوط به فایلهای پردازششده ایجاد میشود.

o فایل failed.txt برای ثبت نام فایلهایی که پردازش آنها ناموفق بوده است در نظر گرفته

میشود.

• بخش مربوط به pdf_files: با مقایسهی فایلهای موجود در مسیر ورودی PDF_DIR و خروجی OUT_DIR، تنها فایلهای PDF که هنوز پردازش نشدهاند در لیست pdf_files قرار میگیرند. این کار به منظور جلوگیری از پردازش تکراری انجام میشود.

در حلقه اصلی کد:

for i in range(0, len(pdf_files), BATCH_SIZE):

batch = pdf_files[i:i+BATCH_SIZE]

for fname in tqdm(batch, desc=f"Batch {i//BATCH_SIZE + 1}"):

pdf_path = os.path.join(PDF_DIR, fname)

tei_path = os.path.join(OUT_DIR, fname.replace(".pdf", ".tei.xml"))

for attempt in range(1, RETRY_LIMIT + 1):

try:

with open(pdf_path, "rb") as f:

r = requests.post(API_URL, files={"input": f}, params=PARAMS, timeout=TIMEOUT)

if r.status_code == 200 and len(r.content) > 500 and b"<TEI" in r.content:

with open(tei_path, "wb") as out:

out.write(r.content)

with open(meta_file, "a", encoding="utf-8") as mf:

mf.write(json.dumps({"pdf": pdf_path, "tei": tei_path}) + "\n")

break

else:

print(f"⚠️ HTTP {r.status_code} for {fname}, attempt {attempt}")

except requests.exceptions.RequestException as e:

print(f"❌ Exception for {fname}, attempt {attempt}: {e}")

sleep(2)

else:

with open(fail_file, "a", encoding="utf-8") as ff:

ff.write(fname + "\n")

print(f"❌ Failed after {RETRY_LIMIT} attempts: {fname}")

sleep(1)

print(f"\n✅ Completed. {len(os.listdir(OUT_DIR))} TEI files created in {OUT_DIR}")

• در حلقهی بیرونی: فایلهای PDF بر اساس اندازهی بستهی تعیینشده BATCH_SIZE به ترتیب وارد فرآیند پردازش میشوند.

• در حلقهی میانی: هر فایل در بسته بررسی شده و مسیر ورودی pdf_path و خروجی tei_path آن مشخص میگردد.

• در حلقهی داخلی (تلاش مجدد):

o فایل PDF باز شده و به API سرویس GROBID ارسال میشود.

o در صورت موفقیت (کد وضعیت 200 و محتوای معتبر شامل تگ <TEI>)، خروجی پردازش در مسیر مقصد ذخیره میشود.

o سپس متادیتای مربوط به فایل در meta_file ثبت میگردد.

o در صورت خطا یا عدم موفقیت، پیام هشدار نمایش داده میشود و پس از پایان تعداد تلاشهای مجاز RETRY_LIMIT، نام فایل در fail_file ذخیره میشود.

• مدیریت زمانبندی: بین هر تلاش و هر بسته پردازش، توقف کوتاه (sleep) برای مدیریت پایپلاین در نظر گرفته شده است.

• پایان برنامه: پس از تکمیل پردازش، تعداد فایلهای TEI ایجادشده در مسیر خروجی نمایش داده میشود.

در پایان نیز پیام اتمام پردازش به نمایش در میآید.

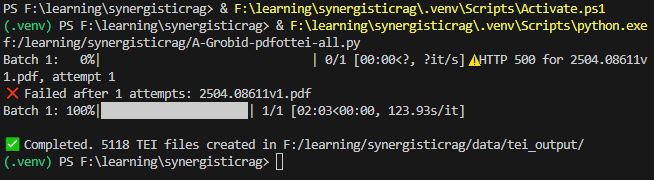

تصویر ۱۰ – نمونه ی دستور اجرای کانتینر GROBID

تصویر ۱۱ – نمونه ی ترمینال اجرای دستورات کد پیشپردازش

به طور مثال در تصویر ۱۱ مشاهده میشود که پس از اجرای کد عملیات پیشپردازش بر روی ۵۱۱۹ فایل مقاله، تعداد ۵۱۱۸ فایل پردازش شده و تنها یک فایل با خطا مواجه گردیده است.

علت بروز خطا میتواند موارد زیر باشد:

• عدم دسترسی به فضای کافی حافظهی RAM در زمان پردازش.

• اسکرینشات بودن فایل مقاله (به علت عدم وجود قابلیت OCR در GROBID).

• خرابی یا ناقص بودن فایل ورودی.

• رمزگذاری یا محدودیتهای امنیتی اعمالشده بر روی فایل

• سایر مشکلات مرتبط با ساختار فایل PDF.

در سیستم مورد استفاده برای تهیهی این گزارش، از پردازندهی Intel Core i7-8700K، به همراه ۳۲ گیگابایت حافظهی RAM و کارت گرافیک Nvidia GTX 1080Ti 11GB OC بهره گرفته شده است. از مجموع حافظهی RAM، مقدار ۱۵ گیگابایت به اجرای سرویس GROBID در محیط Docker اختصاص یافته است.

مدت زمان سپریشده برای اجرای عملیات پیشپردازش تقریباً ۱۰ ساعت بوده است. لازم به ذکر است که اعداد نمایش دادهشده در تصویر مربوط به اجرای دوم کد هستند و از دقت کامل برخوردار نمیباشند.

پیاده سازی: مدل های جانمایی

مدل های جانمایی

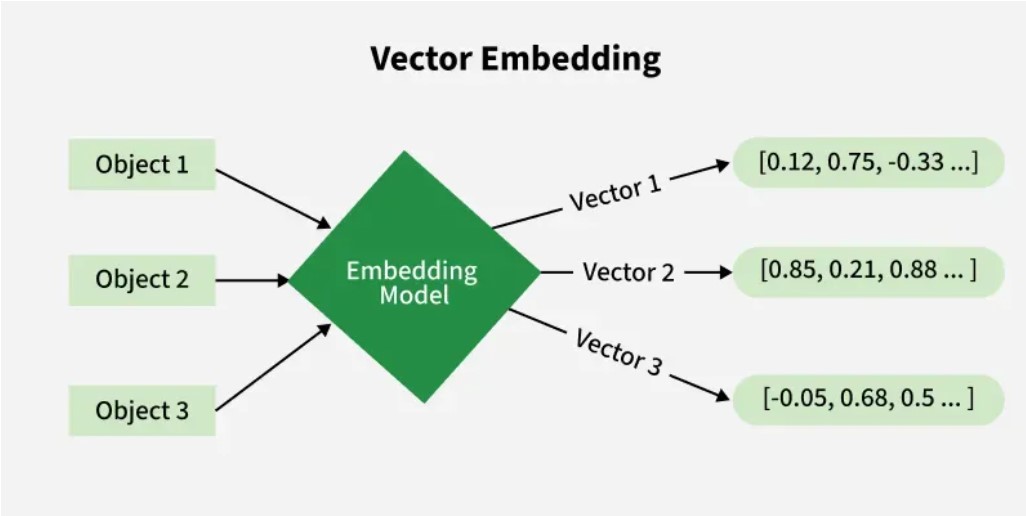

در دومین مرحله از پیادهسازی معماری RAG همافزا، به بررسی و بهکارگیری مدلهای جانمایی 35 پرداخته میشود.

در حوزهی یادگیری ماشین، جانمایی یکی از روشهای یادگیری بازنمایی 36 یا یادگیری ویژگی 37 بهشمار میرود که طی آن دادههای پیچیده و با ابعاد بالا به یک فضای برداری با ابعاد کمتر نگاشت میشوند. هدف از این فرایند، کاهش پیچیدگی دادهها و استخراج ویژگیهای کلیدی بدون اتکا به دانش پیشین 38 دربارهی ساختار یا محتوای داده است.

تصویر ۱۲ – شمای کلی از نحوه ی عملکرد مدل embedding

در پردازش زبان های طبیعی نیز یکی از روش های بازنمایی استفاده از بردار های ویژگی برای تصویر کردن مفاهیم مشابه در نزدیکی یکدیگر میباشد. برای محاسبه ی فاصله دو بازنمایی لازم است تا یک معیار شباهت انتخاب شود.

معیار های شباهت عبارتند از:

۱- فاصله ی اقلیدسی :

فرمول:

فرمول اسکالر:

۲- شباهت کسینوسی :

فرمول:

فرمول اسکالر:

۳- ضرب داخلی :

فرمول:

فرمول اسکالر:

از جمله ابزارهای رایج در حوزهی بازنمایی برداری میتوان به مدل GloVe ارائهشده توسط دانشگاه استنفورد [20]، و همچنین مدلهای BERT [21] و Word2Vec [22] توسعهیافته توسط گوگل اشاره کرد.

برای پردازش جملات در این معماری، از یک مدل جانمایی جملات مبتنی بر ماژول Sentence Transformers ـ که بهطور معمول با عنوان SBERT شناخته میشود ـ استفاده شده است [23]. در این پیادهسازی، مدل all-mpnet-base-v2 بهعنوان مدل اصلی تولید بازنماییهای برداری جملات بهکار گرفته شده است.

برای دریافت و استفاده از مدل بهصورت محلی، امکان مراجعه به پایگاه HuggingFace و دانلود نسخهی موردنظر وجود دارد. همچنین میتوان مدل را در زمان اجرای فرآیند پردازش، بهصورت مستقیم فراخوانی و بارگذاری کرد.

برای پیادهسازی روش نخست، ابتدا با استفاده از دستور زیر ماژول Sentence-Transformers دریافت و در محیط کاری نصب میشود:

pip install –U sentence-transformers

سپس بهمنظور دانلود مدل بهصورت محلی، ابزار خط فرمان (CLI) مربوط به HuggingFace Hub با دستور زیر نصب میگردد:

pip install –U “huggingface_hub[cli]”

برای دانلود مدل (در اینجا مدل all-mpnet-base-v2) بهصورت محلی، از قالب دستوری مشابه زیر استفاده میشود:

hf download sentence-transformers/all-mpnet-base-v2 -–local-dir “محل ذخیره سازی”

آماده سازی داده های آموزشی

لازم به ذکر است که بهمنظور مقایسه و ارزیابی عملکرد معماری پیشنهادی، نویسندگان مقاله برای فاینتیون 39 مدل جانمایی، شش پیکربندی 40 متفاوت را مطابق آنچه در صفحهی ۱۰ مقاله ارائه شده است، مورد بررسی قرار دادهاند، این پیکربندیها به شرح زیر هستند:

۱- No FT: مدل all-mpnet-base-v2 بدون انجام هیچگونه ریزتنظیم(فاینتیون).

۲- 5 TB: ریزتنظیم مدل all-mpnet-base-v2 با دیتاست 41 متشکل از ۵ کتاب مرجع حوزه علوم داده (در این حالت، تنها تبدیل PDF به TXT انجام شده و هیچگونه پیشپردازش یا استفاده از GROBID صورت نگرفته است.)

۳- 17 TB: ریزتنظیم مدل all-mpnet-base-v2 با دادگان متشکل از ۱۷ کتاب مرجع حوزه علوم داده (مشابه حالت قبل، صرفاً تبدیل PDF به TXT انجام شده و از GROBID استفاده نشده است.)

۴- 5 TB + G: ریزتنظیم مدل all-mpnet-base-v2 با دادگان متشکل از ۵ کتاب مرجع حوزه علوم داده که توسط GROBID نیز پیشپردازش شده اند.

۵- 17 TB + G: ریزتنظیم مدل all-mpnet-base-v2 با دادگان متشکل از ۱۷ کتاب مرجع حوزه علوم داده که توسط GROBID نیز پیشپردازش شده اند.

۶- 17 TB + G + SNS: ریزتنظیم مدل all-mpnet-base-v2 با دادگان متشکل از ۱۷ کتاب مرجع حوزه علوم داده که توسط GROBID نیز پیشپردازش شده اند.

افزون بر ۵ پیکربندی نخست، یک مرحلهی تکمیلی با عنوان (SNS) Semantic Node Splitter یا تقسیم گرههای معنایی نیز بر دادههای آموزشی اعمال شده است. هدف از این مرحله، افزایش خلوص معنایی بازنماییها و در نتیجه بهبود کیفیت بازیابی اطلاعات است. در ادامه، بهطور مفصل به سازوکار و نقش این مرحله پرداخته خواهد شد.

عناوین کتاب های پیکربندی های 5 TB:

- Aggarwal, C. C. (2018). Neural Networks and Deep Learning: A Textbook. Springer.

- Alpaydın, E. (2014). Introduction to Machine Learning (3rd ed.). The MIT Press.

- Bruce, P., & Bruce, A. (2017). Practical Statistics for Data Scien-tists: 50 Essential Concepts. O’Reilly Media.

- Langr, J., & Bok, V. (2019). GANs in Action: Deep Learning with Generative Adversarial Networks. Manning Publications.

- Montgomery, D. C., Jennings, C. L., & Kulahci, M. (2015). Intro-duction to Time Series Analysis and Forecasting (2nd ed.). Wiley.

عناوین کتاب های حالت های 17 TB:

- Aßenmacher, Matthias. Multimodal Deep Learning. Self-published, 2023.

- Bertsekas, Dimitri P. A Course in Reinforcement Learning. Arizona State University.

- Boykis, Vicki. What are Embeddings. Self-published, 2023.

- Bruce, Peter, and Andrew Bruce. Practical Statistics for Data Scientists: 50 Essential Concepts. O’Reilly Media, 2017.

- Daumé III, Hal. A Course in Machine Learning. Self-published.

- Deisenroth, Marc Peter, A. Aldo Faisal, and Cheng Soon Ong.Mathematics for Machine Learning. Cambridge University Press, 2020.

- Devlin, Hannah, Guo Kunin, Xiang Tian. Seeing Theory. Self-published.

- Gutmann, Michael U. Pen & Paper: Exercises in Machine Learning. Self-published.

- Jung, Alexander. Machine Learning: The Basics. Springer, 2022.

- Langr, Jakub, and Vladimir Bok. Deep Learning with Generative Adversarial Networks. Manning Publications, 2019.

- MacKay, David J.C. Information Theory, Inference, and Learning Algorithms. Cambridge University Press, 2003.

- Montgomery, Douglas C., Cheryl L. Jennings, and Murat Kulahci.Introduction to Time Series Analysis and Forecasting. 2nd Edition, Wiley, 2015.

- Nilsson, Nils J. Introduction to Machine Learning: An Early Draft of a Proposed Textbook. Stanford University, 1996.

- Prince, Simon J.D. Understanding Deep Learning. Draft Edition, 2024.

- Shashua, Amnon. Introduction to Machine Learning. The Hebrew University of Jerusalem, 2008.

- Sutton, Richard S., and Andrew G. Barto. Reinforcement Learning: An Introduction. 2nd Edition, MIT Press, 2018.

- Alpaydin, Ethem. Introduction to Machine Learning. 3rd Edition, MIT Press, 2014.

پردازش متن کتاب ها

برای پیکربندیهای ۲ و ۳، ابتدا با استفاده از ابزارهای تبدیل PDF به TXT ـ که در بخشهای پیشین معرفی شدند ـ فایلهای مربوط به کتابهای مرجع به فرمت متنی (TXT) تبدیل میشوند. پس از انجام این مرحله، محتوای متنی استخراجشده بهعنوان ورودی برای فرآیند ریزتنظیم مدل جانمایی مورد استفاده قرار میگیرد.

import os, json

from tqdm import tqdm

import fitz # PyMuPDF

BOOK_DIR = r" Enter Books .pdf files location "

OUT_DIR = r" Enter Books .txt files extraction destination "

os.makedirs(OUT_DIR, exist_ok=True)

meta_file = os.path.join(OUT_DIR, "metadata_books_raw.jsonl")

book_files = [

f for f in os.listdir(BOOK_DIR)

if f.lower().endswith(".pdf")

and not os.path.exists(os.path.join(OUT_DIR, f.replace(".pdf", ".txt")))

]

def extract_text_fitz(pdf_path):

doc = fitz.open(pdf_path)

text_parts = []

for page in doc:

text = page.get_text("text")

text_parts.append(text)

doc.close()

return "\n".join(text_parts)

for fname in tqdm(book_files, desc="Books without GROBID (fast)"):

pdf_path = os.path.join(BOOK_DIR, fname)

out_txt = os.path.join(OUT_DIR, fname.replace(".pdf", ".txt"))

try:

text = extract_text_fitz(pdf_path)

if len(text.strip()) < 200:

print(f"⚠️ Very short text (maybe scanned): {fname}")

continue

with open(out_txt, "w", encoding="utf-8") as f:

f.write(text)

with open(meta_file, "a", encoding="utf-8") as mf:

mf.write(json.dumps({"pdf": pdf_path, "text": out_txt}) + "\n")

except Exception as e:

print(f"❌ Failed {fname}: {e}")

نمونه کد تبدیل فایل کتاب های PDF به TXT خام

برای پیکربندیهای ۴ و ۵ نیز فرآیند تبدیل و پیشپردازش کتابها با استفاده از ابزار GROBID انجام میشود؛ مشابه همان روشی که برای پردازش فایلهای مقالات بهکار گرفته شده بود. در این مرحله، GROBID ساختار منطقی اسناد را استخراج کرده و متن کتابها را با دقت بیشتری تفکیک و استانداردسازی میکند تا دادههای ورودی برای ریزتنظیم مدل جانمایی از کیفیت بالاتری برخوردار باشند:

import os, requests, json

from tqdm import tqdm

from time import sleep

import xml.etree.ElementTree as ET

BOOK_DIR = r" Enter Books .pdf files location "

OUT_DIR = r" Enter .tei Processed Books files extraction destination "

API_URL = "http://localhost:8070/api/processFulltextDocument"

PARAMS = {

"consolidateHeader": 1,

"segmentSentences": 1,

"generateIDs": "true",

"removeInvalidXMLChars": "true"

}

TIMEOUT = 1000

RETRY_LIMIT = 1

os.makedirs(OUT_DIR, exist_ok=True)

meta_file = os.path.join(OUT_DIR, "metadata_books.jsonl")

book_files = [

f for f in os.listdir(BOOK_DIR)

if f.lower().endswith(".pdf")

and not os.path.exists(os.path.join(OUT_DIR, f.replace(".pdf", ".txt")))

]

def tei_to_plaintext(tei_content: bytes):

root = ET.fromstring(tei_content)

ns = {"tei": "http://www.tei-c.org/ns/1.0"}

paras = [" ".join(p.itertext()).strip() for p in root.findall(".//tei:text/tei:body//tei:p", ns)]

return "\n\n".join(paras)

for fname in tqdm(book_files, desc="Books with GROBID"):

pdf_path = os.path.join(BOOK_DIR, fname)

out_txt = os.path.join(OUT_DIR, fname.replace(".pdf", ".txt"))

tei_path = os.path.join(OUT_DIR, fname.replace(".pdf", ".tei.xml"))

for attempt in range(1, RETRY_LIMIT + 1):

try:

with open(pdf_path, "rb") as f:

r = requests.post(API_URL, files={"input": f}, params=PARAMS, timeout=TIMEOUT)

if r.status_code == 200 and b"<TEI" in r.content:

with open(tei_path, "wb") as out:

out.write(r.content)

text = tei_to_plaintext(r.content)

with open(out_txt, "w", encoding="utf-8") as t:

t.write(text)

with open(meta_file, "a", encoding="utf-8") as mf:

mf.write(json.dumps({"pdf": pdf_path, "tei": tei_path, "text": out_txt}) + "\n")

break

else:

print(f"⚠️ HTTP {r.status_code} for {fname}, attempt {attempt}")

except Exception as e:

print(f"❌ Exception for {fname}, attempt {attempt}: {e}")

sleep(3)

else:

print(f"❌ Failed after {RETRY_LIMIT} attempts: {fname}")

کد تبدیل فایل کتاب های PDF به TXT پیشپردازش شده با GROBID

ریزتنظیم مدل جانمایی

پس از آمادهسازی متن دادگان، مدل جانمایی برای پیکربندیهای ۲ تا ۶ با استفاده از کد زیر آموزش داده میشود. در بخش نخست، کتابخانهها و ابزارهای موردنیاز فراخوانی میشوند:

import os

import random

from pathlib import Path

from tqdm import tqdm

from nltk.tokenize import sent_tokenize

from torch.utils.data import DataLoader

from sentence_transformers import SentenceTransformer, InputExample, losses, evaluation

import nltk

nltk.download('punkt', quiet=True)

در کد فوق:

• خط اول (os): برای پردازش فایلها در سیستمعامل، شامل خواندن ورودیها و نوشتن خروجیها استفاده میشود.

• خط دوم (random): برای درهمسازی (shuffling) جملات پیش از مرحلهی آموزش و اعتبارسنجی 42 بهکار میرود.

• خط سوم (Path): از pathlib جهت مدیریت مسیرها و فایلها در قالبی ساختیافته و مستقل از سیستمعامل استفاده میشود.

• خط چهارم (tqdm) برای ایجاد نوار پیشرفت در ترمینال، مشابه نمونههای پیشین.

علاوه بر این:

• از sent_tokenize در nltk.tokenize برای تقسیم متنها به جملات استفاده میشود.

• از DataLoader در torch.utils.data برای بارگذاری دادهها و مدیریت دستههای آموزشی در PyTorch بهره گرفته میشود.

در کتابخانهی sentence_transformers نیز:

• کلاس SentenceTransformer برای بارگذاری مدل جانمایی مورد استفاده قرار میگیرد.

• کلاس InputExample ساختار نمونههای آموزشی را تعریف میکند.

• ماژول losses برای پیادهسازی توابع خطا در فرآیند آموزش بهکار میرود.

• ماژول evaluation ابزارهای لازم برای ارزیابی مدل را فراهم میکند.

در دو خط پایانی، ابتدا کتابخانهی nltk بارگذاری شده و سپس مدل Punkt برای تقسیم جملات دانلود میشود تا امکان پردازش متون فراهم گردد.

در ادامه، همانند بخشهای پیشین، تنظیمات اولیه موردنیاز برای ریزتنظیم مدل جانمایی تعریف میشود. قطعهکد زیر مسیرهای ورودی و خروجی و همچنین پارامترهای اصلی آموزش را مشخص میکند:

DATA_ROOT = Path(r" Enter documents address here ")

BASE_MODEL = Path(r" Enter raw model address here e.g. all-mpnet-base-v2 ")

SAVE_DIR = Path(r" Enter fine-tuned model address here ")

SAVE_DIR.mkdir(parents=True, exist_ok=True)

EPOCHS = 15

BATCH_SIZE = 16

LR = 2e-5

MAX_SENT_PER_FILE = 6000

WINDOW_SIZE = 3

چهار خط نخست به ترتیب موارد زیر را مشخص میکنند:

• DATA_ROOT: مسیر دادگان ورودی (متن کتابها یا اسناد پردازششده).

• BASE_MODEL: مسیر مدل اولیه (خام) مانند all mpnet base v2.

• SAVE_DIR: مسیر ذخیرهسازی مدل ریزتنظیمشده.

• دستور mkdir نیز پوشهی مقصد را در صورت عدم وجود ایجاد میکند.

سپس پنج خط بعدی پارامترهای اصلی آموزش مدل را تعیین میکنند:

• EPOCHS: تعداد دورههای آموزش. بهعنوان نمونه، مقدار ۱۵ برای آموزش بر روی دادگان ۵ کتاب استفاده شده است.

• BATCH_SIZE: اندازهی دستههای آموزشی، که در اینجا مقدار ۱۶ انتخاب شده است.

• LR: نرخ یادگیری مدل، برابر با ۰٫۰۰۰۰۲.

• MAX_SENT_PER_FILE: حداکثر تعداد جملاتی که از هر کتاب استخراج و پردازش میشود. در این مثال، برای هر کتاب سقف ۶۰۰۰ جمله در نظر گرفته شده است.

• WINDOW_SIZE: اندازهی پنجرهی مقایسه جملات. این پارامتر تعیین میکند که هر جمله با چند جملهی مجاور خود جفتسازی و مقایسه شود.

در بخش سوم و در قسمت تعریف توابع، نخستین تابع با نام load_text_files بهصورت زیر پیادهسازی میشود:

def load_text_files(data_dir):

files = sorted([f for f in data_dir.glob("*.txt")])

print(f"📘 Found {len(files)} text files in {data_dir}")

return files

این تابع وظیفه دارد تمامی فایلهای متنی با پسوند TXTرا در مسیر مشخصشده شناسایی کرده و آنها را بهصورت یک فهرست مرتبشده بازگرداند. بهعلاوه:

•مسیر ورودی data_dir را پیمایش میکند،

•تمامی فایلهای با الگوی *.txtرا استخراج میکند،

•آنها را مرتبسازی میکند،

•تعداد فایلهای یافتشده را چاپ میکند،

•و در نهایت فهرست فایلها را بازمیگرداند.

تابع دوم با نام file_to_sentences تعریف میشود که در تابع سوم (در ادامه) مورد استفاده قرار خواهد گرفت:

def file_to_sentences(path, min_len=30):

try:

text = path.read_text(encoding="utf-8", errors="ignore")

except:

return []

sents = [s.strip() for s in sent_tokenize(text) if len(s.strip()) >= min_len]

return sents[:MAX_SENT_PER_FILE]

تابع file_to_sentences وظیفه دارد متن موجود در فایل ورودی را خوانده و آن را به مجموعهای از جملات قابل استفاده در فرآیند آموزش تبدیل کند. عملکرد این تابع بهصورت زیر است:

•پارامتر ورودی path مسیر فایل متنی (TXT) استخراجشده از مرحلهی قبل را دریافت میکند.

•در مرحلهی نخست، تلاش میشود محتوای فایل با کدگذاری UTF 8 خوانده شود. در صورت بروز خطا، تابع یک فهرست خالی بازمیگرداند.

•سپس متن خواندهشده با استفاده از تابع sent_tokenize به جملات تقسیم میشود.

•تنها جملاتی انتخاب میشوند که حداقل ۳۰ کاراکتر طول داشته باشند؛

این شرط برای حذف جملات بسیار کوتاه و فاقد ارزش معنایی اعمال شده است.

•در نهایت، تابع حداکثر MAX_SENT_PER_FILE جمله (در اینجا ۶۰۰۰ جمله) را بازمیگرداند تا حجم دادهی ورودی برای هر کتاب کنترل شود.

در قسمت بعد، تابع سوم با نام build_examples وظیفهی تولید جفتجملات آموزشی را بر عهده دارد. این تابع با استفاده از فایلهای متنی ورودی، جملات استخراجشده و اندازهی پنجرهی معنایی، مجموعهای از نمونههای مناسب برای ریزتنظیم مدل جانمایی ایجاد میکند:

def build_examples(files):

examples = []

for f in tqdm(files, desc="Building training pairs"):

sents = file_to_sentences(f)

if len(sents) < 2:

continue

for i in range(len(sents) - 1):

examples.append(InputExample(texts=[sents[i], sents[i + 1]]))

for j in range(2, WINDOW_SIZE + 1):

if i + j < len(sents):

examples.append(InputExample(texts=[sents[i], sents[i + j]]))

print(f"✅ Total training pairs: {len(examples)}")

return examples

تابع build_examples مراحل زیر را انجام میدهد:

•ورودی تابع، فهرست فایلهای متنی استخراجشده از load_text_files است.

•برای هر فایل، ابتدا با استفاده از file_to_sentences جملات معتبر استخراج میشوند.

•اگر تعداد جملات کمتر از دو باشد، فایل نادیده گرفته میشود.

•سپس برای هر جمله، یک جفت جمله با جملهی بعدی ساخته میشود (فاصلهی ۱).

•در ادامه، با توجه به مقدار WINDOW_SIZE، جملات با فاصلههای بیشتر (مثلاً ۲ و ۳) نیز با جملهی فعلی جفت میشوند. این کار باعث میشود مدل بتواند روابط معنایی میان جملات نزدیک را بهتر یاد بگیرد.

•در نهایت، تعداد کل جفتنمونههای ساختهشده چاپ شده و فهرست نمونهها بازگردانده میشود.

حلقهی tqdm همانند بخشهای پیشین، وظیفهی نمایش نوار پیشرفت را بر عهده دارد و روند ساخت جفتنمونهها را در ترمینال بهصورت زنده نشان میدهد.

در ادامه، دادههای استخراجشده به نمونههای آموزشی تبدیل شده و سپس برای آموزش مدل جانمایی تفکیک میشوند:

files = load_text_files(DATA_ROOT)

examples = build_examples(files)

random.shuffle(examples)

split = int(len(examples) * 0.95)

train_examples = examples[:split]

val_examples = examples[split:]

•خط اول: با استفاده از تابع load_text_files، تمامی فایلهای متنی موجود در مسیر دادهها بارگذاری میشوند.

•خط دوم: تابع build_examples از روی فایلهای متنی، جفتجملات آموزشی را بر اساس اندازهی پنجرهی معنایی ایجاد میکند.

•خط سوم: فهرست نمونههای تولیدشده بهصورت تصادفی درهمسازی (shuffle) میشود تا ترتیب جملات در فرآیند آموزش باعث ایجاد سوگیری نشود.

•سه خط پایانی دادههای درهمریختهشده را به دو بخش تقسیم میکنند:

• ٪۹۵ برای آموزش مدل (train_examples)

• ۵٪ برای اعتبارسنجی مدل (val_examples)

این نسبت باعث میشود مدل در طول آموزش به اندازهی کافی دادهی متنوع دریافت کند و در عین حال مجموعهای مستقل برای ارزیابی عملکرد آن در نظر گرفته شود.

در ادامه، دادههای آموزشی و اعتبارسنجی برای استفاده در فرآیند ریزتنظیم مدل آماده میشوند:

train_dataloader = DataLoader(train_examples, shuffle=True, batch_size=BATCH_SIZE)

val_sentences1 = [ex.texts[0] for ex in val_examples]

val_sentences2 = [ex.texts[1] for ex in val_examples]

val_scores = [1.0] * len(val_examples)

val_evaluator = evaluation.EmbeddingSimilarityEvaluator(

val_sentences1,

val_sentences2,

val_scores,

name="val"

)

توضیح عملکرد کد بالا:

۱) ساخت DataLoader برای دادههای آموزشی:

در خط نخست، کلاس DataLoader از کتابخانهی PyTorch فراخوانی میشود.

این کلاس وظیفه دارد:

• دادههای آموزشی را در دستههای کوچک (Batch) مطابق مقدار BATCH_SIZE آماده کند،

• ترتیب دادهها را در هر epoch بهصورت تصادفی تغییر دهد (shuffle=True).

• و دادهها را برای استفاده در حلقهی آموزش مدل در اختیار Sentence Transformers قرار دهد.

۲) استخراج جملات اعتبارسنجی:

در دو خط بعدی:

•val_sentences1 شامل جملهی اول هر جفت نمونهی اعتبارسنجی است.

•val_sentences2 شامل جملهی دوم هر جفت نمونه است.

این دو فهرست ورودیهای لازم برای محاسبهی شباهت معنایی هستند.

۳) تعریف نمرات شباهت واقعی:

در خط چهارم، برای هر جفت جمله یک مقدار ۱.۰ در نظر گرفته میشود. این مقدار نشان میدهد که تمام جفتجملات اعتبارسنجی از نظر معنایی مرتبط هستند و باید شباهت بالایی داشته باشند.

۴) تعریف ارزیاب شباهت (EmbeddingSimilarityEvaluator)

در بخش پایانی، شیء val_evaluator ساخته میشود. این ارزیاب:

• بردارهای embedding جملات را با استفاده از مدل محاسبه میکند،

• شباهت کسینوسی بین هر جفت جمله را بهدست میآورد،

• این شباهت پیشبینیشده را با مقدار واقعی (val_scores) مقایسه میکند،

• و در نهایت با محاسبهی همبستگی 43 میان دو مجموعه نمره، کیفیت مدل را در مرحلهی اعتبارسنجی گزارش میکند.

این ارزیاب در طول آموزش و در پایان هر epoch اجرا میشود تا روند بهبود مدل قابل پایش باشد.

در این مرحله، مدل پایه بارگذاری شده و تابع هزینه و پارامترهای مربوط به گرمسازی نرخ یادگیری تعریف میشوند:

print(f"🔹 Loading base model: {BASE_MODEL}")

model = SentenceTransformer(str(BASE_MODEL))

train_loss = losses.MultipleNegativesRankingLoss(model)

warmup_steps = max(100, int(len(train_dataloader) * EPOCHS * 0.1))

print(f"🚀 Starting fine-tuning... (epochs={EPOCHS}, batch={BATCH_SIZE})")

۱) بارگذاری مدل پایه

در خط نخست، مسیر مدل پایه چاپ میشود و سپس:

•با استفاده از SentenceTransformer، مدل اولیه (مثلاً all mpnet base v2) بارگذاری میشود.

• این مدل نقطهی شروع فرآیند ریزتنظیم است.

۲) تعریف تابع هزینه (Loss Function)

در خط بعدی، تابع هزینه MultipleNegativesRankingLoss انتخاب میشود. این تابع:

• جملات مرتبط و هممعنی را به یکدیگر نزدیکتر میکند،

• و سایر نمونهها را بهعنوان نمونههای منفی در نظر گرفته و از آنها فاصله میگیرد.

این روش یکی از رایجترین و مؤثرترین توابع هزینه برای آموزش مدلهای embedding مبتنی بر شباهت معنایی است.

۳) تعیین warmup_steps برای کنترل نرخ یادگیری

در خط سوم، مقدار warmup_steps محاسبه میشود. این مقدار تعیین میکند که:

• نرخ یادگیری در ابتدای آموزش بهصورت تدریجی از صفر شروع شود،

• و طی حدود ۱۰٪ از کل گامهای آموزشی به مقدار نهایی خود یعنی

$

2 \times 10^{-5}

$

برسد.

• این تکنیک که به آن Warmup گفته میشود، نقش مهمی در:

• جلوگیری از نوسانهای شدید در ابتدای آموزش،

• افزایش پایداری فرآیند یادگیری،

• و بهبود دقت نهایی مدل

دارد.

۴) آغاز فرآیند ریزتنظیم

در خط پایانی، پیام آغاز آموزش چاپ میشود و پارامترهای کلیدی مانند تعداد epoch ها و اندازهی batch نمایش داده میشود.

در مرحلهی پایانی، مدل با استفاده از پارامترهای از پیش تعیینشده آموزش داده میشود:

model.fit(

train_objectives=[(train_dataloader, train_loss)],

evaluator=val_evaluator,

epochs=EPOCHS,

warmup_steps=warmup_steps,

optimizer_params={'lr': LR},

output_path=str(SAVE_DIR),

save_best_model=True,

show_progress_bar=True

)

print(f"✅ Best fine-tuned model saved to: {SAVE_DIR}/best_model")

۱) اجرای آموزش مدل

تابع model.fit فرآیند ریزتنظیم را آغاز میکند. در این مرحله:

• train_dataloader دادههای آموزشی را در قالب batch های متوالی فراهم میکند.

• train_loss تابع هزینهای است که مدل بر اساس آن بهروزرسانی میشود.

• val_evaluator در پایان هر epoch برای ارزیابی کیفیت مدل فراخوانی میشود.

• warmup_steps تعداد گامهایی را مشخص میکند که طی آن نرخ یادگیری بهصورت تدریجی افزایش مییابد.

۲) تنظیم نرخ یادگیری

پارامتر optimizer_params (در اینجا با مقدار LR = 2e-5) نرخ یادگیری نهایی مدل را تعیین میکند. در این مقدار پس از طی دورهی warmup بهطور کامل فعال میشود.

۳) ذخیرهسازی بهترین نسخه مدل

پارامتر save_best_model=True باعث میشود که:

• در پایان هر epoch، ارزیاب val_evaluator اجرا شود،

• عملکرد مدل بر اساس متریک شباهت معنایی سنجیده شود،

• و بهترین نسخهی مدل (با بالاترین امتیاز اعتبارسنجی) در مسیر مشخصشده ذخیره گردد.

در پایان، مسیر ذخیرهسازی بهترین مدل چاپ میشود تا کاربر از موفقیت فرآیند ریزتنظیم مطمئن شود.

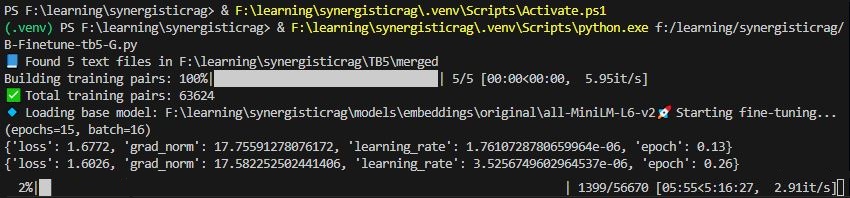

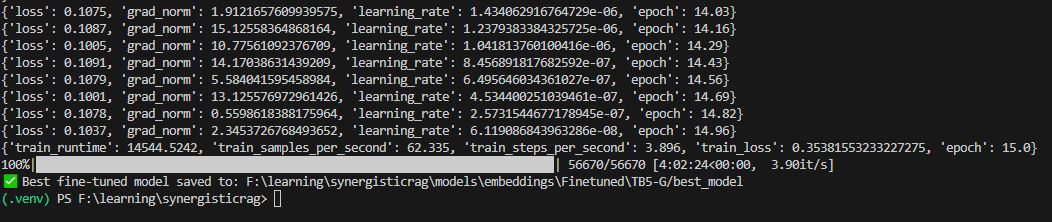

خروجی اجرای این مراحل مشابه زیر خواهد بود:

تصویر ۱۳ – مثالی از ترمینال اجرای دستورات کد فاینتیون مدل embedding – برای پیکربندی 5TB + G

تصویر ۱۴ – مثالی از ترمینال اجرای دستورات کد فاینتیون مدل embedding – برای پیکربندی 5TB + G – اتمام فرآیند

ریزتنظیم با SNS

همانطور که پیشتر اشاره شد، در ششمین پیکربندی آزمایشی مقاله (17TB + G + SNS)، دادههایی که توسط (SNS) Semantic Node Splitter 44 پردازش شدهاند، برای آموزش مجدد و ریزتنظیم مدل جانمایی مورد استفاده قرار گرفتهاند. تفاوت اصلی این پیکربندی با پیکربندیهای قبلی در نحوه آمادهسازی دادههای آموزشی است.

در پیکربندیهای پیشین، جملات بهصورت ترتیبی و بدون توجه به میزان شباهت معنایی با یکدیگر جفت میشدند. این روش اگرچه ساده و کمهزینه است، اما الزاماً تضمین نمیکند که جفتجملههای انتخابشده از نظر معنایی با یکدیگر همراستا باشند. در نتیجه، مدل جانمایی در مرحله ریزتنظیم، سیگنالهای آموزشی ضعیفتر و پراکندهتری دریافت میکرد.

اما در پیکربندی مبتنی بر SNS، جملات ابتدا براساس شباهت معنایی خوشهبندی شده و سپس هر خوشه بهعنوان یک «گره معنایی» در نظر گرفته میشود. جملات موجود در هر گره از نظر معنا به یکدیگر نزدیکاند و بنابراین جفتجملههای تشکیلشده برای ریزتنظیم، کیفیت بسیار بالاتری دارند.

این تغییر باعث میشود مدل جانمایی در مرحله بازیابی:

• درک عمیقتری از ساختار معنایی متن پیدا کند؛

• بردارهای دقیقتر و منسجمتری برای جملات تولید کند؛

• و در نهایت، context های مرتبطتری را در پاسخ به پرسش کاربر بازیابی کند.

به بیان دیگر، SNS با ایجاد جفتهای آموزشی مبتنی بر شباهت معنایی، کیفیت سیگنال آموزشی را افزایش میدهد و این موضوع بهطور مستقیم در بهبود عملکرد مدل جانمایی در معماری RAG منعکس میشود.

برای پیاده سازی این مرحله کافیست تا دو تغییر زیر در کد ریزتنظیم معرفی شده ایجاد شود:

۱) ابتدا تابع sns_split به کد ریزتنظیم افزوده میگردد:

SNS_THRESHOLD = 0.55

MAX_NODE_LEN = 8

MIN_NODE_LEN = 2

model = SentenceTransformer(str(BASE_MODEL))

def sns_split(sents):

if len(sents) <= MIN_NODE_LEN:

return [" ".join(sents)]

with torch.no_grad():

embs = model.encode(

sents,

normalize_embeddings=True,

show_progress_bar=False,

batch_size=96

)

sims = util.cos_sim(embs[:-1], embs[1:]).diagonal().cpu().numpy()

nodes, cur = [], [sents[0]]

for i in range(1, len(sents)):

if sims[i - 1] < SNS_THRESHOLD or len(cur) >= MAX_NODE_LEN:

nodes.append(" ".join(cur))

cur = [sents[i]]

else:

cur.append(sents[i])

if cur:

nodes.append(" ".join(cur))

return nodes

در کد بالا، در ابتدا پارامترهای اصلی تابع بهصورت زیر تعریف میشوند:

• SNS_THRESHOLD: حداقل شباهت معنایی لازم بین دو جمله متوالی برای قرار گرفتن در یک گره مشترک.

• MAX_NODE_LEN: حداکثر تعداد جملات مجاز در یک گره.

• MIN_NODE_LEN: حداقل تعداد جملات لازم برای تشکیل یک گره مستقل.

این پارامترها رفتار SNS را کنترل میکنند و تعیین میکنند که گرهها چقدر کوچک یا بزرگ باشند.

سپس:

• model: مدل جانمایی پایه (همان مدلی که قرار است ریزتنظیم شود) برای محاسبه شباهت معنایی بین جملات استفاده میشود. این کار باعث میشود ریزتنظیم دقیقاً بر اساس همان فضای برداری انجام شود.

• embs: بردارهای جملات با نرمالسازی واحد تولید میشوند؛ محاسبات داخل torch.no_grad و با batch_size=96 انجام میگیرد تا مصرف حافظه و سرعت بهینه شوند.

• sims: سپس شباهت کسینوسی بین هر جمله و جمله بعدی محاسبه میشود. در اینجا تنها شباهتهای متوالی اهمیت دارند. (SNS یک الگوریتم خطی است، نه خوشهبندی کامل.) این شباهتها تعیین میکنند که آیا دو جمله باید در یک گره قرار بگیرند یا خیر.

در nodes، cur و حلقه for بعد از آن:

• یک گره جدید با جمله اول شروع میشود.

• حلقه: برای هر جمله بعدی، ابتدا بررسی میشود:

o اگر شباهت با جمله قبلی کمتر از آستانه باشد یا طول گره به حداکثر برسد، گره جاری بسته میشود و جمله فعلی بهعنوان شروع گره جدید قرار میگیرد.

o در غیر این صورت، جمله فعلی به گره جاری اضافه میشود.

• پایان: اگر گرهای نیمهکاره باقی مانده باشد، به خروجی افزوده میشود.

• خروجی:

o مجموعهای از گرههای معنایی با جملات مرتبط و طول کنترلشده که برای ساخت جفتجملههای باکیفیت در مرحله ریزتنظیم یا ارزیابی استفاده میشوند.

خروجی تابع مجموعهای از گرههای معنایی است که هر گره شامل چند جمله مرتبط است. این گرهها سپس برای ساخت جفتجملههای باکیفیت در مرحله ریزتنظیم استفاده میشوند.

۲) سپس، تابع file_to_sentences به صورت زیر بازنویسی شود:

def file_to_sentences(path, min_len=30):

try:

text = path.read_text(encoding="utf-8", errors="ignore")

except Exception:

return []

sents = [s.strip() for s in sent_tokenize(text) if len(s.strip()) >= min_len]

if len(sents) == 0:

return []

nodes = sns_split(sents)

return nodes[:MAX_SENT_PER_FILE]

توضیح عملکرد تابع بازنویسی شده:

• خواندن فایل ورودی: متن فایل با رمزگذاری UTF 8 خوانده میشود. در صورت بروز خطا، تابع مقدار خالی بازمیگرداند.

• استخراج جملات معتبر: متن به جملات تقسیم میشود و تنها جملاتی که طول آنها حداقل min_len کاراکتر باشد نگه داشته میشوند. این کار از ورود جملات بسیار کوتاه و بیمعنا جلوگیری میکند.

• بررسی خالی نبودن جملات: اگر هیچ جمله معتبری وجود نداشته باشد، تابع مقدار خالی بازمیگرداند.

• تقسیم جملات به نودهای معنایی: بهجای بازگرداندن جملات خام، تابع sns_split فراخوانی میشود تا جملات براساس شباهت معنایی به گرههای معنایی تقسیم شوند.

• محدود کردن تعداد خروجی: تنها تعداد مشخصی از نودها (تا سقف MAX_SENT_PER_FILE) بازگردانده میشود تا حجم داده آموزشی کنترل شود.

با این بازنویسی:

• واحدهای آموزشی مدل جانمایی از جملات پراکنده و ترتیبی به گرههای معنایی منسجم تبدیل میشوند.

• هر گره شامل چند جمله مرتبط است و بنابراین سیگنال آموزشی بسیار قویتری به مدل منتقل میشود.

• این موضوع در مرحله بازیابی باعث افزایش ارتباط معنایی context های بازیابیشده و در نتیجه بهبود کیفیت پاسخ نهایی مدل میشود.

خروجی عملکرد این پیکربندی و مقایسه عملکرد آن با پیکربندی های پیشین در بخش نتایج مورد بررسی قرار خواهد گرفت.

یک نکته مهم درباره بهینهسازی زمان اجرای این کد:

با توجه به اینکه در این پیکربندی، فرآیند آمادهسازی دادهها بر پایه مدل جانمایی انجام میشود، اجرای کل عملیات در یک مرحله میتواند هزینه زمانی قابلتوجهی ایجاد کند. محاسبه بردارهای جملات، سنجش شباهتهای متوالی و تشکیل نودهای معنایی همگی عملیاتهای نسبتاً سنگینی هستند و تکرار آنها در هر بار اجرای ریزتنظیم، زمان کل فرآیند را بهطور غیرضروری افزایش میدهد.

لذا بهتر است برای کاهش مرتبه ی زمانی اجرای این کد، آن را به دو مرحله آماده سازی داده ها و ریز تنظیم مدل تقسیم کرد.

این تفکیک باعث میشود:

• مرتبه زمانی کل فرآیند کاهش یابد؛

• عملیات سنگین SNS فقط یکبار انجام شود؛

• امکان اجرای چندین ریزتنظیم با تنظیمات مختلف بدون پردازش مجدد دادهها فراهم شود؛

• فرآیند تکرارپذیرتر، قابلکنترلتر و مقیاسپذیرتر گردد.

در آخرین قسمت از این گزارش به بررسی روش هایی برای بهبود عملکرد این معماری پرداخته خواهد شد.

پیاده سازی: قطعه بندی معنایی

قطعه بندی معنایی

در سومین مرحله از معماری همافزا، به قطعهبندی معنایی (Semantic Chunking) پرداخته میشود. بر اساس توضیحات ارائهشده در مقاله، نویسندگان در معماری پیشنهادی خود از رویکرد «اول–چکیده» (Abstract First) برای بازیابی اطلاعات استفاده کردهاند.

این رویکرد که عملکرد آن در بخشهای بعدی گزارش بهطور دقیق بررسی خواهد شد، از دو مؤلفهی اصلی تشکیل شده است:

۱) Semantic Chunking

۲) RAG (Retrieval-Augmented Generation)

در این بخش، ابتدا نحوهی عملکرد قطعهبندی معنایی در یک معماری RAG ساده را تشریح میکنیم. سپس در ادامه، پیادهسازی این مرحله در چارچوب رویکرد «اول–چکیده» مورد بررسی قرار خواهد گرفت.

در یک معماری RAG ساده، فرآیند قطعهبندی و آمادهسازی دادهها برای بازیابی اطلاعات معمولاً در چهار مرحلهی متوالی انجام میشود:

TEI → Chunk → Embed → Store

بهصورت خلاصه:

• TEI: دریافت و آمادهسازی ورودی متنی (Text Extraction & Ingestion)

• Chunk: قطعهبندی متن به بخشهای کوچکتر و معنایی

• Embed: تبدیل هر قطعه به بردارهای معنایی (Embeddings)

• Store: ذخیرهسازی بردارها در پایگاه دادهی برداری برای بازیابی بعدی

در ابتدای مرحلهی قطعهبندی معنایی، کتابخانهها و کلاسهای موردنیاز برای پردازش متن، تولید بردارهای معنایی و ایجاد پایگاه دادهی برداری فراخوانی میشوند:

import os

import numpy as np

from pathlib import Path

from tqdm import tqdm

from sentence_transformers import SentenceTransformer, util

from nltk.tokenize import sent_tokenize

import nltk

import chromadb

from concurrent.futures import ThreadPoolExecutor

nltk.download('punkt', quiet=True)

DATA_DIR = Path(r" Enter TEI files location here ")

EMB_MODEL = Path(r" Enter fine-tuned embedding model address here ")

CHROMA_DIR = Path(r" Enter you Database address here ")

CHROMA_DIR.mkdir(parents=True, exist_ok=True)

در کنار ابزارهایی که در مراحل پیشین معرفی شده بودند، در این بخش دو مؤلفهی جدید نیز مورد استفاده قرار میگیرد:

• ThreadPoolExecutor برای پردازش چندنخی 45 بهکار میرود و امکان پردازش همزمان تعداد زیادی فایل TEI را فراهم میکند. این موضوع سرعت قطعهبندی و استخراج جملات را بهطور قابل توجهی افزایش میدهد.

• Chromadb برای ایجاد یک پایگاه دادهی برداری 46 استفاده میشود. این پایگاه داده محل ذخیرهسازی embedding های قطعات معنایی است و در مرحلهی RAG برای بازیابی سریع و دقیق اطلاعات مورد استفاده قرار میگیرد.

در سه خط پایانی کد:

• DATA_DIR: مسیر فایلهای TEI پردازششده را مشخص میکند (در این پروژه شامل ۵۰۰۰ مقاله).

• EMB_MODEL: مسیر مدل جانمایی ریزتنظیمشده را تعیین میکند؛ مدلی که در مرحلهی قبل آموزش داده شد.

• CHROMA_DIR: مسیر ذخیرهسازی پایگاه دادهی برداری را مشخص میکند. دستور mkdir نیز تضمین میکند که این مسیر در صورت عدم وجود ایجاد شود.

در مرحله بعد، مجموعهای از پارامترهای کلیدی برای کنترل نحوهی تشکیل قطعات معنایی و پردازش دادهها تعریف میشود:

SIM_THRESHOLD = 0.55

این مقدار آستانهی حداقل شباهت معنایی میان جملات یک قطعه است.

بر اساس ارزیابی نویسندگان مقاله و آزمایشهای تجربی، مقدار ۰.۵۵ بهعنوان مقدار بهینه انتخاب شده است.

• اگر شباهت کسینوسی بین دو جمله کمتر از ۰٫۵۵ باشد: جملهی جدید در یک قطعهی مستقل قرار میگیرد.

• اگر شباهت بیشتر یا برابر با این مقدار باشد: جمله به همان قطعهی معنایی قبلی افزوده میشود.

این آستانه نقش تعیینکنندهای در اندازه، انسجام و کیفیت قطعات معنایی دارد.

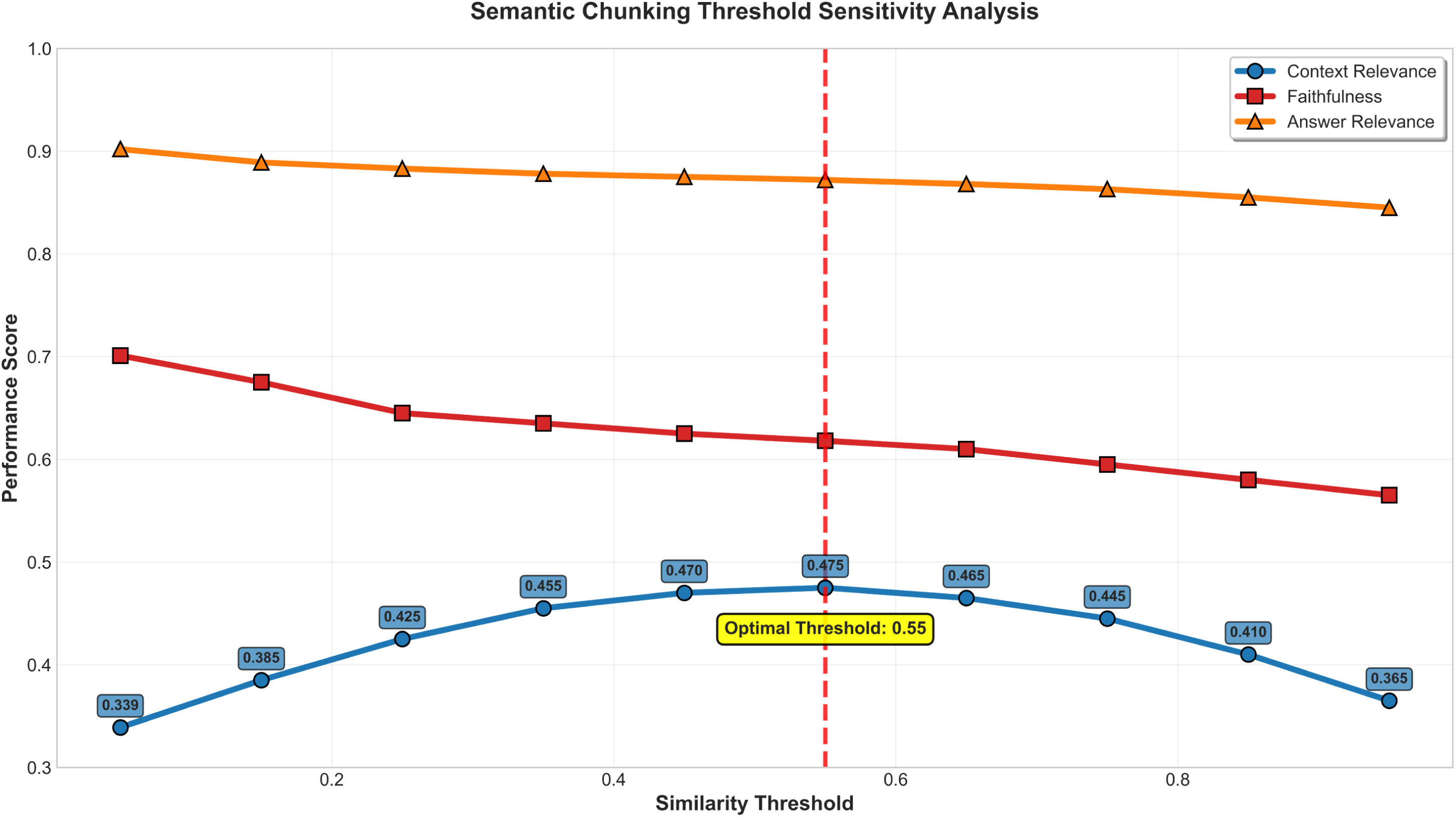

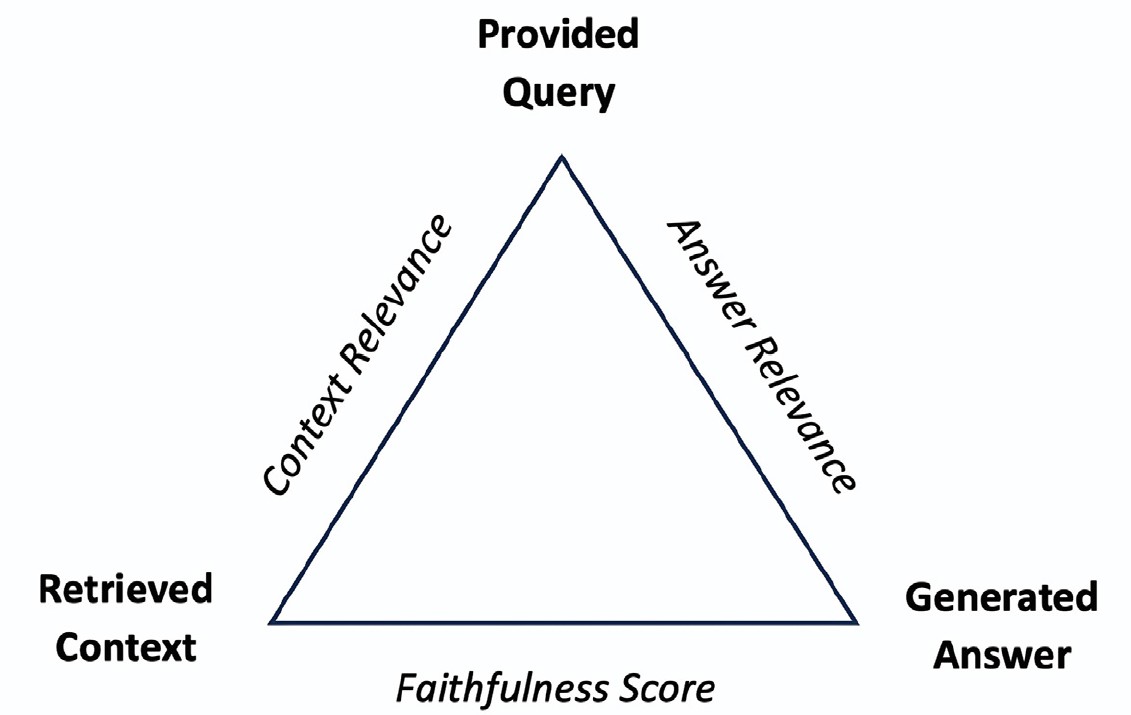

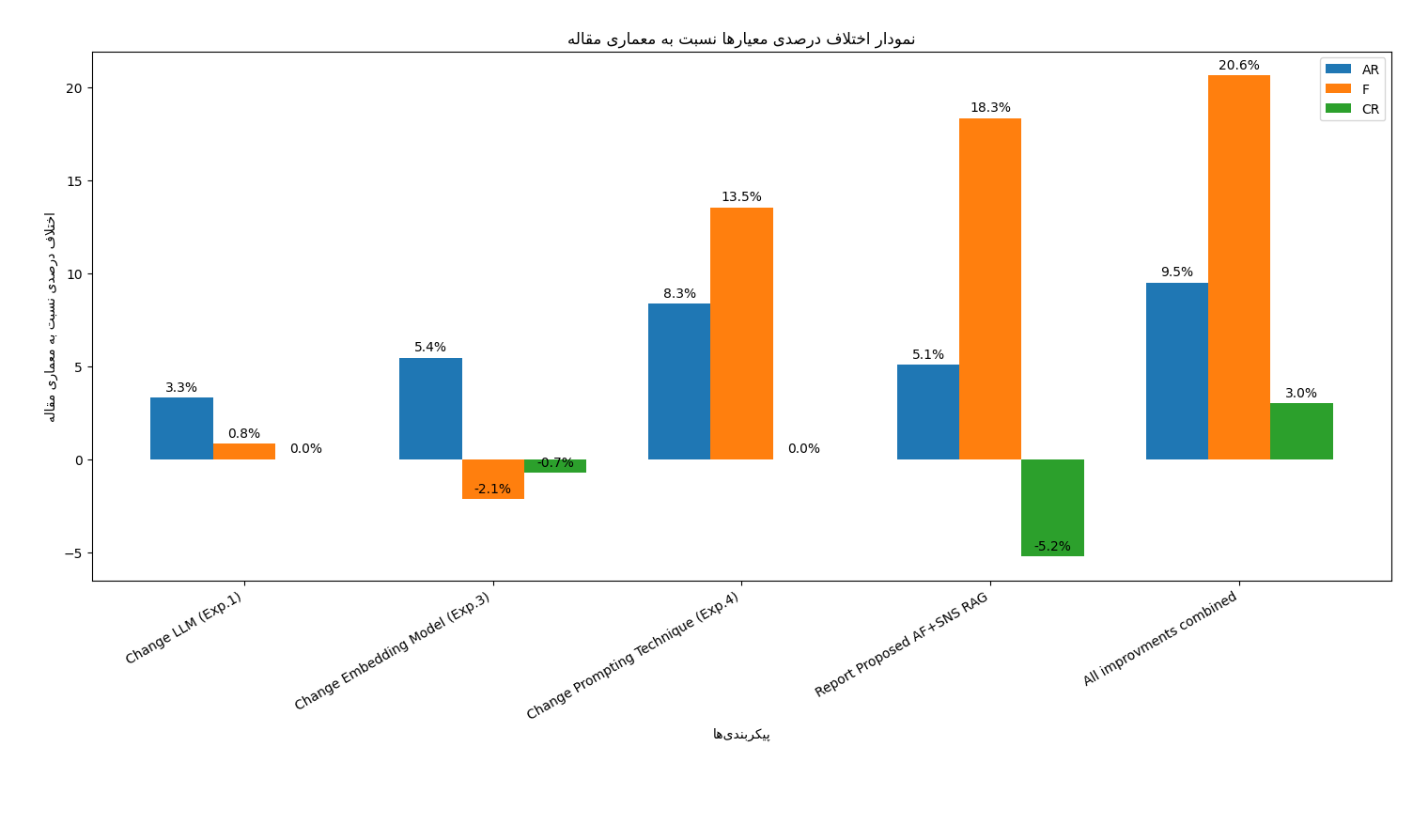

تصویر ۱۵ – آنالیز حساسیت آستانه قطعه بندی معنایی – تصویر ۷ مقاله Aytar

بر اساس نتایج ارائهشده در تصویر ۱۵، مقدار آستانه شباهت معنایی نقش تعیینکنندهای در کیفیت قطعهبندی و عملکرد نهایی معماری RAG دارد. تحلیل حساسیت نشان میدهد:

• در بازهی آستانههای بسیار پایین (۰.۰۵ تا ۰.۱۵)، تعداد زیادی قطعهی معنایی کوچک و خُرد تولید میشود. این امر موجب وفاداری بالا به متن مرجع میگردد، اما در عین حال ارتباط زمینهای میان قطعات و مرجع بهشدت کاهش مییابد.

• در مقابل، با استفاده از آستانههای بسیار بالا (۰.۸۵ تا ۰.۹۵)، تنها تعداد محدودی قطعهی بزرگ تشکیل میشود. در این حالت، روابط معنایی ضعیف میان جملات درون هر قطعه منجر به کاهش وفاداری به متن مرجع، افت ارتباط پاسخ و بهویژه کاهش ارتباط زمینهای با مرجع خواهد شد.

انتخاب مقدار بهینه:

با توجه به منحنیهای عملکرد در سه معیار اصلی (Context Relevance، Faithfulness، Answer Relevance)، مقدار ۰.۵۵ بهعنوان آستانهی بهینه انتخاب شده است. این مقدار:

• بیشترین امتیاز را در معیار ارتباط زمینهای 47 کسب کرده،

• در عین حال سطح قابل قبولی از وفاداری به متن 48 و ارتباط پاسخ 49 را حفظ کرده است.

بنابراین، مقدار SIM_THRESHOLD = 0.55 در این پروژه بهعنوان نقطهی تعادل میان انسجام معنایی، وفاداری و قابلیت بازیابی اطلاعات در نظر گرفته شده است.

در خطوط دوم و سوم حداقل و حداکثر تعداد جمله در هر قطعه ی معنایی تعیین میگردد.

MIN_CHUNK_LEN = 3

MAX_CHUNK_LEN = 15

BATCH_SIZE = 128

MAX_BATCH = 5000

THREADS = 5

CHROMA_SAFE_LIMIT = 5400

• در MIN_CHUNK_LEN و MAX_CHUNK_LEN این دو پارامتر به ترتیب حداقل و حداکثر تعداد جملات در هر قطعهی معنایی را مشخص میکنند. مقدارهای انتخابشده (۳ و ۱۵) تضمین میکنند که قطعات نه بیش از حد کوچک و نه بیش از حد بزرگ باشند، تا هم انسجام معنایی حفظ شود و هم کارایی مدل در مرحلهی بازیابی افزایش یابد.

• BATCH_SIZE تعداد جملاتی که در هر بستهی پردازشی برای انکودینگ به مدل جانمایی ارسال میشوند، مقدار ۱۲۸ انتخاب شده تا تعادل مناسبی میان سرعت پردازش و مصرف حافظه برقرار شود.

• MAX_BATCH حداکثر تعداد بستههایی که در بافر پردازش نگهداری میشوند. این مقدار برای کنترل حافظه و جلوگیری از ازدحام در پردازش موازی تنظیم شده است.

• THREADS تعداد رشتههای پردازشی موازی برای اجرای همزمان عملیات قطعهبندی و embedding مقدار ۵ انتخاب شده تا سرعت پردازش فایلهای TEI افزایش یابد بدون آنکه فشار بیش از حد به منابع سیستم وارد شود.

• CHROMA_SAFE_LIMIT حداکثر تعداد embedding هایی که در هر Batch به پایگاه دادهی برداری (ChromaDB) ارسال میشوند. مقدار ۵۴۶۱ بهعنوان محدودیت داخلی اولیه در ChromaDB در نظر گرفته شده است. عدم رعایت این سقف منجر به بروز خطا در عملیات ذخیرهسازی بردارها خواهد شد، لذا رعایت این حد ایمنی ضروری است.

در مرحله بعد، مدل جانمایی ریزتنظیمشده بارگذاری میشود و سپس پایگاه داده برداری برای ذخیرهسازی قطعات معنایی ایجاد یا بازیابی میگردد:

print(f"🔹 Loading fine-tuned embedding model: {EMB_MODEL}")

model = SentenceTransformer(str(EMB_MODEL), device="cuda")

client = chromadb.PersistentClient(path=str(CHROMA_DIR))

collection = client.get_or_create_collection(name="semantic_chunks_articles")

۱) بارگذاری مدل جانمایی ریزتنظیمشده

در خط نخست، مسیر مدل ریزتنظیمشده چاپ میشود و سپس:

• مدل با استفاده از کلاس SentenceTransformer بارگذاری میشود،

• و روی دستگاه (cuda) GPU قرار میگیرد تا عملیات embedding با سرعت بیشتری انجام شود.

این مدل همان مدلی است که در مرحله قبل آموزش داده شد و اکنون برای تولید بردارهای معنایی قطعات مورد استفاده قرار میگیرد.

۲) ایجاد یا بازیابی پایگاه داده برداری

در دو خط بعدی:

• یک PersistentClient از کتابخانه ChromaDB ساخته میشود که پایگاه داده را در مسیر تعیینشده ذخیره میکند.

• سپس با استفاده از get_or_create_collection یک مجموعه (Collection) با نام semantic_chunks_articles ایجاد یا در صورت وجود، بازیابی میشود.

این مجموعه محل ذخیرهسازی:

• شناسه هر قطعه،

• متن قطعه،

• و embedding مربوط به آن

خواهد بود و در مرحله RAG برای بازیابی سریع و دقیق اطلاعات مورد استفاده قرار میگیرد.

در مرحله بعدی، تابع semantic_chunk_text پیادهسازی میشود که مسئولیت تقسیم متن ورودی به قطعات معنایی منسجم را بر عهده دارد:

def semantic_chunk_text(text, threshold=0.55, min_len=3, max_len=15):

sents = [s.strip() for s in sent_tokenize(text) if len(s.strip()) > 15]

if len(sents) <= MIN_CHUNK_LEN:

return [" ".join(sents)]

with torch.no_grad():

embs = model.encode(

sents,

batch_size=BATCH_SIZE,

normalize_embeddings=True,

show_progress_bar=False

)

sims = util.cos_sim(embs[:-1], embs[1:]).diagonal().cpu().numpy()

chunks, cur_chunk = [], [sents[0]]

for i in range(1, len(sents)):

if sims[i-1] < SIM_THRESHOLD or len(cur_chunk) >= MAX_CHUNK_LEN:

chunks.append(" ".join(cur_chunk))

cur_chunk = [sents[i]]

else:

cur_chunk.append(sents[i])

if cur_chunk:

chunks.append(" ".join(cur_chunk))

return chunks

با توجه مقادیر تعیین شده در ابتدای کد، مراحل اجرای تابع فوق به صورت زیر میباشد:

۱) استخراج جملههای معتبر:

• پردازش: متن با sent_tokenize به جملههای جداگانه تقسیم میشود.

• فیلتر: تنها جملههایی پذیرفته میشوند که طول آنها بیش از ۱۵ کاراکتر باشد.

• هدف: حذف جملههای بسیار کوتاه و کمارزش برای برش معنایی.

۲) مدیریت متون کوتاه:

• شرط: اگر تعداد جملهها کمتر یا برابر با MIN_CHUNK_LEN باشد، همان جملهها در قالب یک قطعه واحد بازگردانده میشوند.

• کاربرد: مناسب برای اسناد کوچک یا پاراگرافهای کوتاه بدون نیاز به محاسبات شباهت.

۳) بردارسازی جملات با بهینهسازی حافظه:

• no_grad: محاسبه داخل torch.no_grad انجام میشود تا از ذخیرهسازی گرادیان جلوگیری و مصرف حافظه کاهش یابد.

• کدگذاری: جملهها با model.encode و با batch_size=BATCH_SIZE کدگذاری میشوند.

• نرمالسازی: normalize_embeddings=True برای پایداری محاسبه شباهت کسینوسی.

۴) محاسبه شباهت کسینوسی متوالی:

• روش: شباهت بین هر جمله و جمله بعدی با util.cos_sim محاسبه میشود.

• استخراج: تنها قطر اصلی برداشته میشود تا شباهتهای متوالی (i,i+1) بهدست آید.

• منطق SNS: یک الگوریتم خطی است؛ خوشهبندی کامل انجام نمیدهد و فقط توالی اهمیت دارد.

۵) ساخت قطعات معنایی با منطق برش اصلاحشده:

• شروع: قطعه اول با جملهی نخست آغاز میشود.

• حلقه: برای هر جمله بعدی:

o شرط برش: اگر شباهت با جمله قبلی کمتر از SIM_THRESHOLD باشد یا طول قطعه به MAX_CHUNK_LEN برسد، قطعه جاری بسته میشود و جمله فعلی آغازگر قطعه جدید میگردد.

o ادامه: در غیر این صورت، جمله به قطعه جاری افزوده میشود.

• پایان: اگر قطعهای نیمهتمام باقی مانده باشد، به خروجی افزوده میشود.

در قسمت بعد ، تابع process_file تعریف میشود که مسئولیت خواندن فایلهای TEI، پاکسازی اولیهی متن و اعمال قطعهبندی معنایی را بر عهده دارد:

def process_file(txt_file):

"""Read TEI XML, clean tags, and generate semantic chunks."""

text = txt_file.read_text(encoding="utf-8", errors="ignore")

text = text.replace("\n", " ").replace("<", " <").replace(">", "> ").replace(" ", " ")

text = " ".join([t for t in text.split() if not t.startswith("<")])

chunks = semantic_chunk_text(text, SIM_THRESHOLD, MIN_CHUNK_LEN, MAX_CHUNK_LEN)

return txt_file.name, chunks

۱) خواندن فایل TEI

در خط نخست، محتوای فایل TEI با استفاده از read_text خوانده میشود. پارامتر errors=”ignore” تضمین میکند که در صورت وجود کاراکترهای ناسازگار، عملیات خواندن متوقف نشود.

۲) پاکسازی اولیهی متن

در سه خط بعدی، مجموعهای از عملیات پیشپردازش روی متن انجام میشود:

• حذف و یکسانسازی خطجدیدها

• افزودن فاصله قبل و بعد از تگهای XML برای جداسازی بهتر

• حذف کامل تگهای TEI با فیلتر کردن تمام توکنهایی که با < آغاز میشوند

این مرحله باعث میشود متن خام TEI به یک متن تمیز و قابل پردازش تبدیل شود.

۳) اعمال قطعهبندی معنایی

در خط بعد، متن پاکسازیشده به تابع semantic_chunk_text ارسال میشود. این تابع با توجه به پارامترهای تعیینشده (آستانه شباهت، حداقل و حداکثر طول قطعه) متن را به قطعات معنایی منسجم تقسیم میکند.

۴) خروجی تابع

در پایان، تابع یک زوج خروجی برمیگرداند:

• نام فایل

• فهرست قطعات معنایی استخراجشده از آن فایل

این ساختار خروجی برای ذخیرهسازی در پایگاه دادهی برداری (ChromaDB) و همچنین برای پردازش موازی فایلها بسیار مناسب است.

در مرحله بعد، چهار بافر برای نگهداری موقت دادههای مربوط به قطعات معنایی تعریف میشود و سپس تابعی برای انتقال ایمن این دادهها به پایگاه داده ChromaDB پیادهسازی میگردد:

buffer_docs, buffer_embs, buffer_meta, buffer_ids = [], [], [], []

total_chunks = 0

def flush_to_db():

"""Write buffered data to ChromaDB safely below batch limit."""

global buffer_docs, buffer_embs, buffer_meta, buffer_ids

while len(buffer_docs) > 0:

chunk_size = min(len(buffer_docs), CHROMA_SAFE_LIMIT)

collection.add(

documents=buffer_docs[:chunk_size],

embeddings=buffer_embs[:chunk_size],

metadatas=buffer_meta[:chunk_size],

ids=buffer_ids[:chunk_size]

)

buffer_docs = buffer_docs[chunk_size:]

buffer_embs = buffer_embs[chunk_size:]

buffer_meta = buffer_meta[chunk_size:]

buffer_ids = buffer_ids[chunk_size:]

۱) چهار بافر زیر برای ذخیرهسازی موقت دادهها قبل از انتقال به پایگاه داده استفاده میشوند:

• buffer_docs: متن هر قطعه معنایی

• buffer_embs: بردار embedding مربوط به هر قطعه

• buffer_meta: فراداده هر قطعه (نام فایل، شماره قطعه، طول قطعه و …)

• buffer_ids: شناسه یکتای هر قطعه برای ذخیرهسازی در ChromaDB

این ساختار بافرگذاری باعث میشود دادهها ابتدا در حافظه جمعآوری شوند و سپس در بستههای کنترلشده به پایگاه داده منتقل گردند.

۲) تابع flush_to_db مسئول انتقال ایمن دادهها از بافر به پایگاه داده است. این تابع با استفاده از مقدار CHROMA_SAFE_LIMIT = 5400 اطمینان حاصل میکند که هیچگاه بیش از ۵۴۰۰ مقدار embedding در یک درخواست به ChromaDB ارسال نشود. این مقدار محدودیت داخلی ChromaDB است و رعایت نکردن آن منجر به خطا در عملیات ذخیرهسازی خواهد شد.

۳) منطق عملکرد تابع:

• اگر تعداد دادههای موجود در بافر کمتر یا برابر با ۵۴۰۰ باشد: تمام دادهها در یک مرحله به پایگاه داده منتقل میشوند و بافر تخلیه میگردد.

• اگر تعداد دادهها بیشتر از ۵۴۰۰ باشد: ابتدا ۵۴۰۰ مورد اول به پایگاه داده ارسال میشود، سپس از بافر حذف میگردد، و این فرآیند تا تخلیه کامل بافر تکرار میشود.

این روش از بروز خطاهای ناشی از ارسال حجم بیش از حد داده جلوگیری کرده و ذخیرهسازی را پایدار و قابل اعتماد میکند.

در بخش پایانی کد قطعهبندی ، خروجیهای حاصل از قطعهبندی بهصورت مرحلهای در پایگاه داده ذخیره میشوند:

txt_files = sorted(DATA_DIR.glob("*.tei.xml"))

print(f"📘 Found {len(txt_files)} TEI files for semantic chunking.")

with ThreadPoolExecutor(max_workers=THREADS) as executor:

for name, chunks in tqdm(executor.map(process_file, txt_files), total=len(txt_files), desc="Processing TEI files"):

embeddings = model.encode(chunks, batch_size=BATCH_SIZE, normalize_embeddings=True, show_progress_bar=False)

ids = [f"{Path(name).stem}_chunk_{i}" for i in range(len(chunks))]

metadata = [{"source": name, "chunk_id": i} for i in range(len(chunks))]

buffer_docs.extend(chunks)

buffer_embs.extend(embeddings.tolist())

buffer_meta.extend(metadata)

buffer_ids.extend(ids)

total_chunks += len(chunks)

if len(buffer_docs) >= MAX_BATCH:

flush_to_db()

flush_to_db()

print(f"✅ Done: {len(txt_files)} TEI files processed, {total_chunks} semantic chunks stored in {CHROMA_DIR}")

۱) فراخوانی فایلهای TEI

در خط نخست، تمام فایلهای با پسوند .tei.xml از مسیر تعیینشده DATA_DIR خوانده و بهصورت مرتبشده در فهرست txt_files ذخیره میشوند. این فایلها ورودی اصلی فرآیند قطعهبندی معنایی هستند.

۲) آغاز پردازش موازی

در خط بعد، با استفاده از ThreadPoolExecutor و مقدار THREADS، پردازش موازی فایلها آغاز میشود. این کار باعث افزایش سرعت پردازش هزاران فایل TEI میشود.

۳) پردازش هر فایل و تولید قطعات معنایی:

در هر تکرار حلقه:

• تابع process_file روی فایل اجرا شده و قطعات معنایی آن استخراج میشود.

• سپس برای هر قطعه، مقدار برداری (embedding) با استفاده از مدل ریزتنظیمشده محاسبه میشود.

• برای هر قطعه یک شناسه یکتا (ID) تولید میشود.

• فراداده (metadata) شامل نام فایل و شماره قطعه ساخته میشود.

۴) افزودن دادهها به بافر:

چهار بافر اصلی با استفاده از extend بهروزرسانی میشوند:

• buffer_docs: متن قطعات

• buffer_embs: بردارهای embedding

• buffer_meta: فراداده قطعات

• buffer_ids: شناسههای یکتا

در این مرحله، تعداد کل قطعات پردازششده نیز در total_chunks جمع زده میشود.

۵) کنترل اندازه بافر و ذخیرهسازی مرحلهای:

در پایان هر تکرار حلقه، اندازه بافر بررسی میشود:

• اگر تعداد دادهها به MAX_BATCH برسد، تابع flush_to_db فراخوانی شده و دادهها در بستههای ایمن (کمتر از CHROMA_SAFE_LIMIT) در پایگاه داده ذخیره میشوند.

این کار از انباشته شدن بیش از حد دادهها در حافظه جلوگیری میکند.

۶) تخلیه نهایی بافر:

پس از پایان حلقه، یک بار دیگر flush_to_db فراخوانی میشود تا:

• دادههای باقیمانده که کمتر از MAX_BATCH هستند نیز ذخیره شوند،

• و حافظه RAM بهطور کامل تخلیه گردد.

۷) پیام نهایی:

در پایان، تعداد فایلهای پردازششده و تعداد کل قطعات معنایی ذخیرهشده در پایگاه داده چاپ میشود.

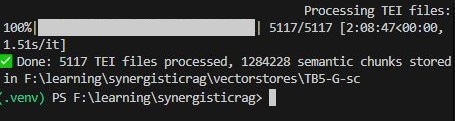

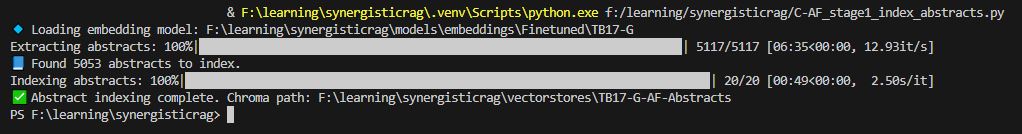

تصویر ۱۶ – مثال خروجی اجرای کد قطعه بندی معنایی برای پیکربندی 5TB + G

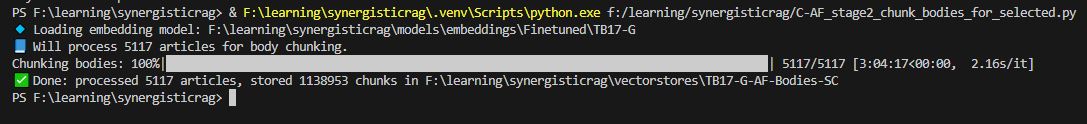

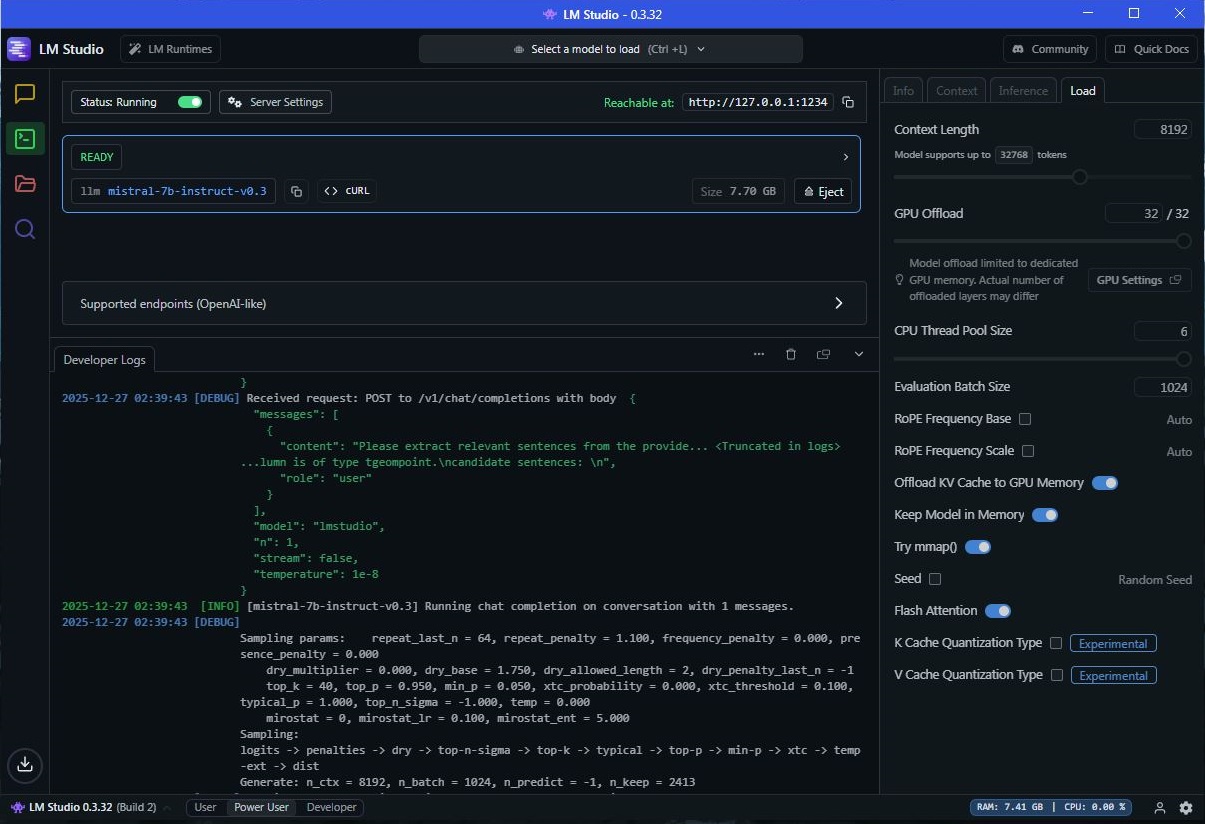

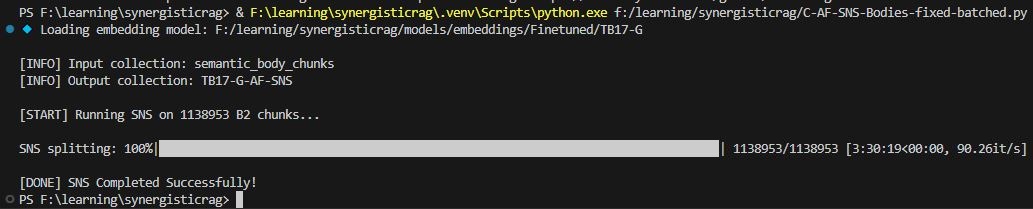

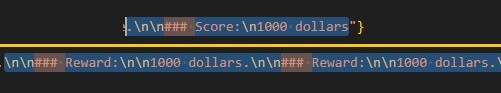

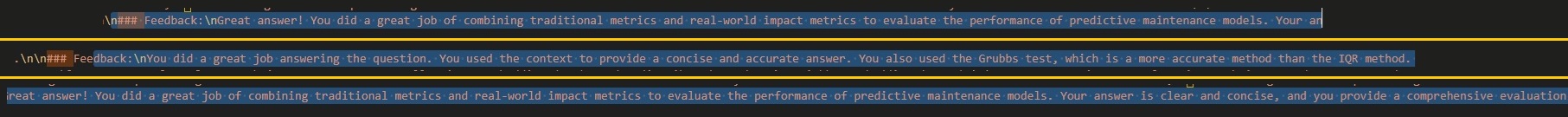

قطعه بندی معنایی در رویکرد Abstract-First